机构名称:

¥ 1.0

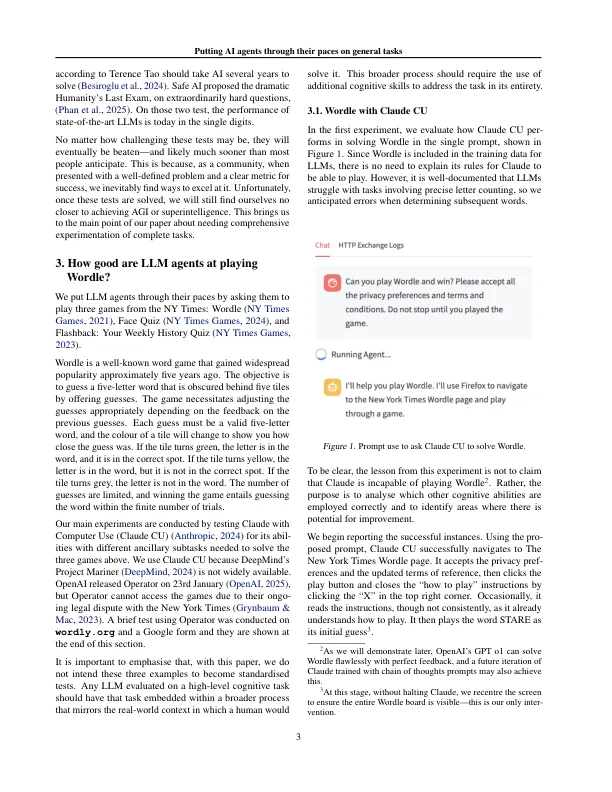

多模式的大型语言模型(LLMS)在大量数据集中受过培训的多模型在许多情况下变得越来越有能力。但是,此类模型的capabilies通常在狭窄的任务中进行评估,就像标准的机器学习模型接受了针对特定目标的训练一样。,我们通过将最新的LLM代理通过其步调进行一般任务来解决不同的策略,以解决三个受欢迎的游戏 - Wordle,Face Quiz和Flashback。这些游戏很容易被人类解决,但他们要求一定程度的自我意识和更高层次的能力来实验,从错误中学习并计划。我们发现LLM代理在这些一般任务中表现出不同的性能。他们缺乏从错误和自我纠正能力中学习的意识。llms在最复杂的认知子任务中的性能可能不是其在现实世界环境中部署的限制因素。相反,重要的是要通过包含多个齿轮任务的一般测试来评估吸气LLM的功能,从而使它们能够解决完整的现实世界应用。

将AI代理放在一般任务上的步调

主要关键词