机构名称:

¥ 2.0

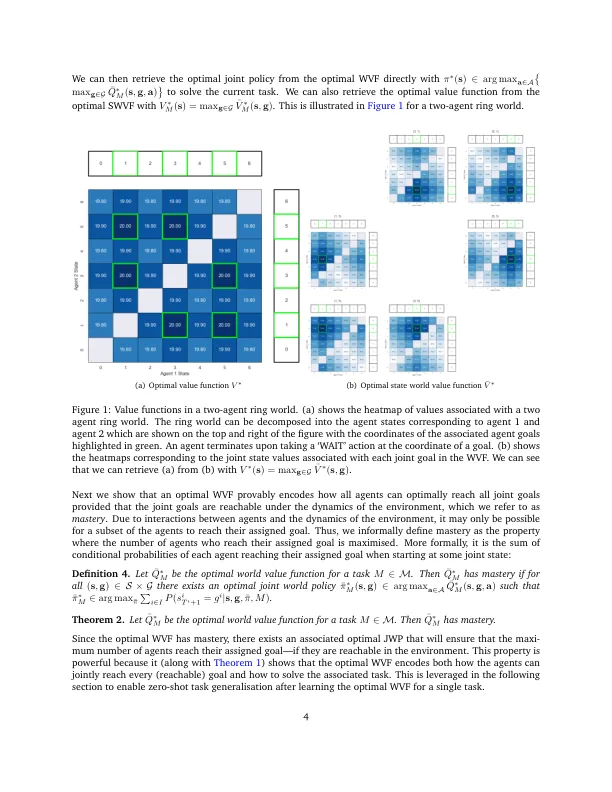

虽然在单药强化学习(RL)的背景下广泛研究了任务概括,但在多代理RL的背景下,很少有研究。确实存在的研究通常将任务概括视为环境的一部分,当明确认为没有理论保证时。我们提出了以目标为导向的多任务多任务多代理RL(GOLEMM)的学习,该方法实现了可以证明是最佳的任务概括,据我们所知,在MARL中还没有实现。在学习了单个任意任务的最佳目标价值函数之后,我们的方法可以零弹性地推断出分布中任何其他任务的最佳策略,仅给出了每个代理的终端奖励的知识,即新任务和学习任务。从经验上我们证明,我们的方法能够概括一个完整的任务分布,而代表性基线只能学习任务分布的一小部分。

合作多代理增强学习中的最佳任务概括