机构名称:

¥ 1.0

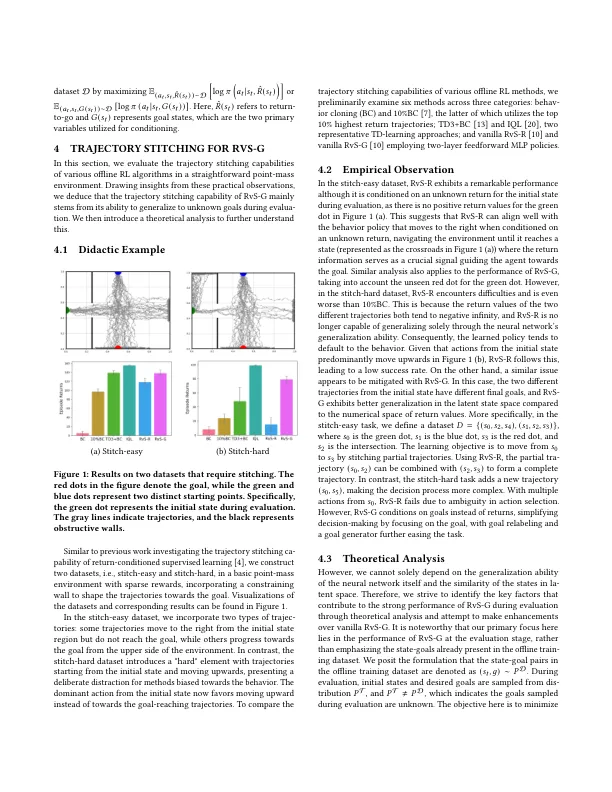

通过监督学习(RVS)进行的加强学习被称为离线增强学习(RL)的新兴范式。虽然返回条件的RVS(RVS-R)在与离线RL任务有关的广泛数据集中占主导地位,但最近的发现表明,目标条件条件的RVS(RVS-G)优于特定的子最好数据集中的轨迹迹象,其中轨迹插入轨迹可用于实现最新功能性能。但是,这种优势的根本原因仍未得到充分探索。在本文中,采用了教学实验和理论分析,我们揭示了RVS-G在缝线轨迹中的熟练程度源于其在评估过程中概括到未知目标方面的熟练性。在这种见解的基础上,我们引入了一种新颖的RVS-G方法,即空间组成RVS(SC-RVS),以增强其概括为未知目标的能力。此反过来又增强了子最佳数据集上的trajectory缝合性能。具体而言,通过利用优势重量的力量和最大透气正则重量,我们的方法可以与现有的RVS-G方法相比,在行动选择中促进乐观目标采样的促进与维护差异的悲观水平。对D4RL基准测试的广泛实验结果表明,在大多数情况下,我们的SC-RV对基准的表现良好,尤其是在需要轨迹缝线的亚最佳数据集上。

增强亚最佳轨迹缝线

主要关键词