机构名称:

¥ 1.0

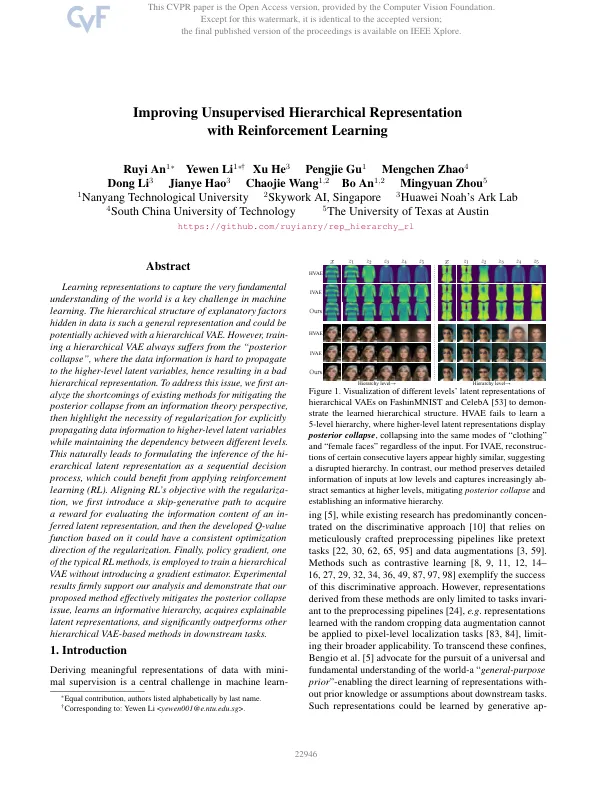

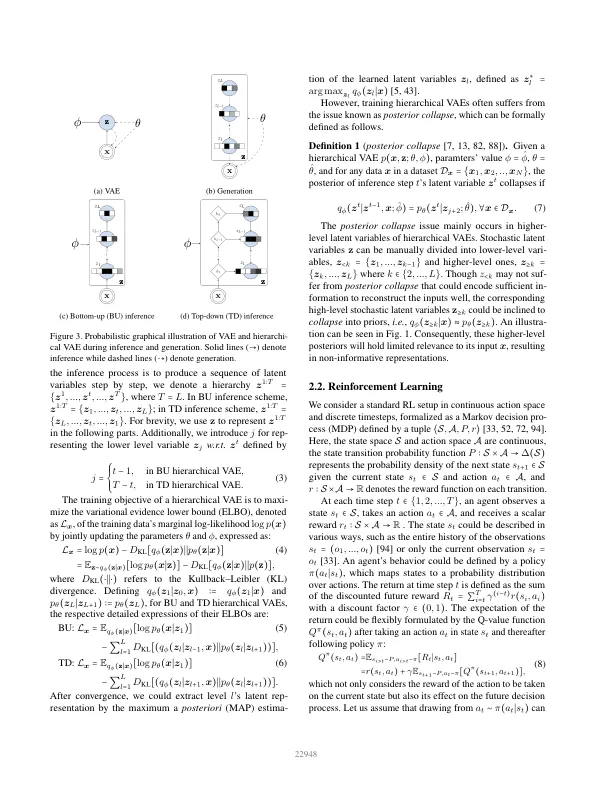

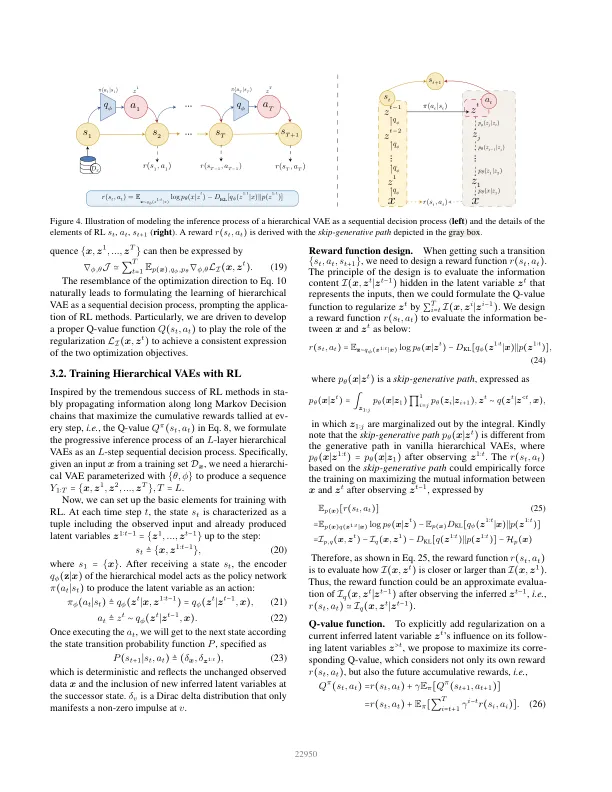

学习表征捕获对世界的非常基本的理解是机器学习的关键挑战。隐藏在数据中的解释因素的层次结构是如此一般的表示,并且可以通过分层VAE实现。然而,培训层次的VAE总是遭受“后塌陷”的苦难,其中数据信息很难传播到更高级别的潜在变量,因此导致层次结构不良。为了解决这个问题,我们首先是从信息理论的角度来减轻后层崩溃的现有方法的缺点,然后突出了正规化的必要性,即在维持不同级别之间的依赖性的同时,将数据信息明确传播到高级潜在变量。这自然会导致提出高级潜在表示作为顺序决策过程的推断,这可能受益于应用强化学习(RL)。将RL的目标与正规化的目标保持一致,我们首先引入了一条跳过的途径,以获取奖励,以评估潜在的潜在表示的信息内容,然后基于它的Q-VALUE函数可能具有正规化的一致优化方向。最后,策略梯度是典型的RL方法之一,用于训练层次VAE,而无需引入梯度估计器。1。简介实验结果坚定地支持我们的分析,并证明我们提出的方法有效地减轻了后塌陷问题,学习了信息的层次结构,获得了可解释的潜在表示,并且在下游任务中明显优于其他基于层次的VAE方法。

通过增强学习

主要关键词