机构名称:

¥ 1.0

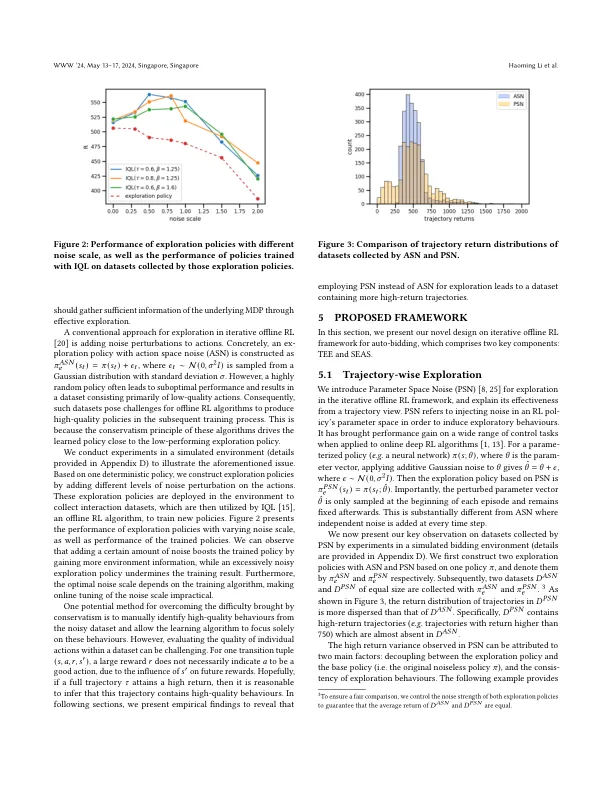

在在线广告中,广告商通常通过使用需求端平台(DSP)提供的自动铸造工具参加广告拍卖的广告广告机会。当前的自动铸造算法通常采用强化学习(RL)。然而,由于安全问题,大多数基于RL的自动竞标政策都经过模拟培训,从而在在线环境中部署时会导致性能退化。要缩小此差距,我们可以并行部署多个自动竞标代理,以收集大型交互数据集。然后可以利用离线RL算法来培训新的政策。随后可以部署训练有素的策略以进行进一步的数据收集,从而产生了迭代培训框架,我们将其称为迭代的离线RL。在这项工作中,我们确定了这种迭代离线RL框架的瓶颈,该框架源自离线RL算法固有的保守主义引起的无效探索和剥削。为了克服这种瓶颈,我们提出了轨迹探索和外观(TEE),它引入了一种新颖的数据收集和数据利用方法,用于从轨迹有偏见的迭代离线RL。此外,为了在保留TEE的数据集质量的同时确保在线探索的安全性,我们建议通过自适应行动选择(SEAS)进行安全探索。在阿里巴巴展示广告平台上的离线实验和现实世界实验都证明了我们提出的方法的有效性。

自动招标的轨迹迭代增强学习框架

主要关键词