机构名称:

¥ 1.0

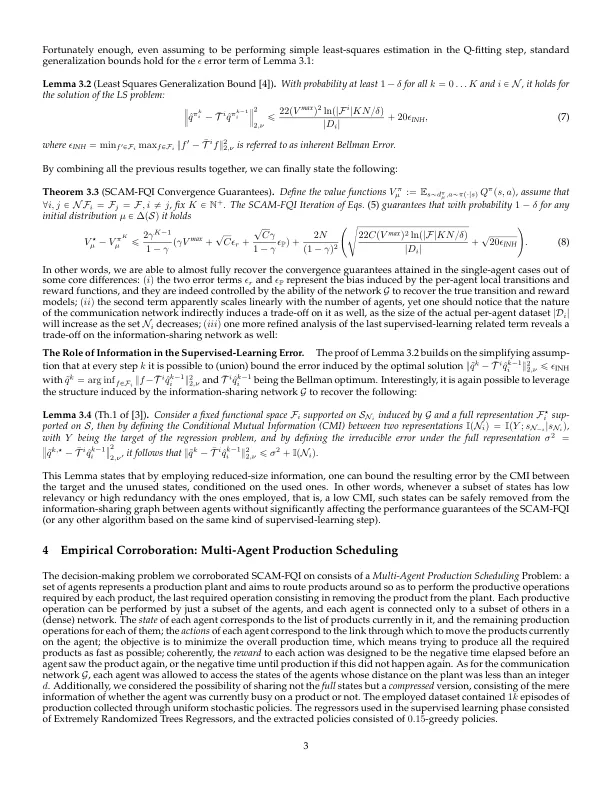

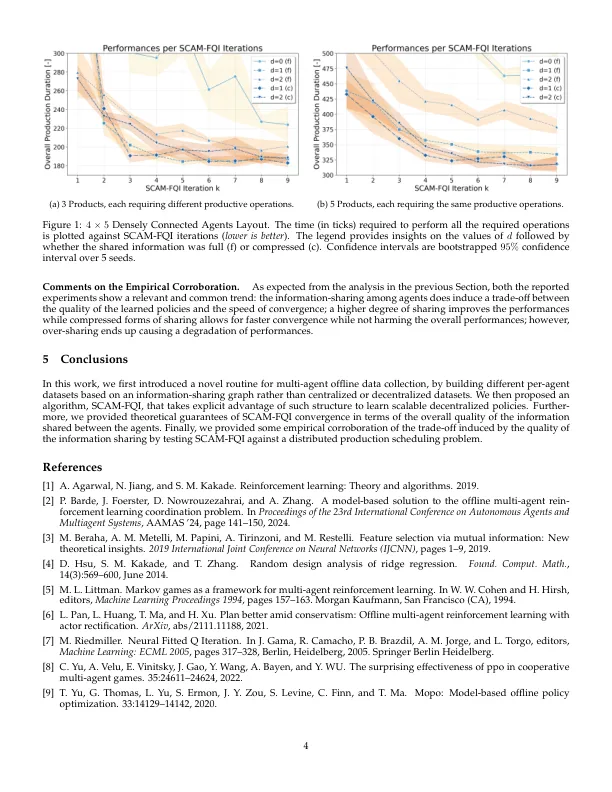

离线增强学习(RL)专注于仅从一批先前收集的数据中学习政策。有可能有效利用此类数据集的潜力,而无需进行昂贵或冒险的主动探索。虽然最近的离线多代理RL(MARL)的最新进展表现出了承诺,但大多数现有方法依赖于所有代理商共同收集的大型数据集,或者是独立收集的特定于特定于代理的数据集。前者的方法确保了强大的性能,但提出了可扩展性的问题,而后者则强调可伸缩性以牺牲性能保证为代价。在这项工作中,我们为数据集收集和离线学习提出了一个新颖的可扩展程序。代理首先通过预先指定的信息共享网络一致地收集了不同的数据集,随后学习了连贯的局限性策略,而无需完全可观察到或倒退以完全分散。从理论上讲,这种结构化方法允许精确拟合的Q-材料(FQI)算法[7]的多代理扩展,以高可能性地汇聚到全球范围内,以降至ϵ-Optimal策略。收敛性受到依赖共享信息信息性的错误术语。此外,我们还展示了这种方法如何将FQI监督学习阶段的固有错误与共享信息和未共享信息之间的共同信息绑定。我们的算法,可扩展的多代理FQI(SCAM-FQI),然后在分布式决策问题上评估。经验结果与我们的理论发现一致,这支持了Scam-FQI在达到可伸缩性和政策绩效之间取得平衡的有效性。

可扩展的多代理离线增强学习和信息的作用

主要关键词