机构名称:

¥ 1.0

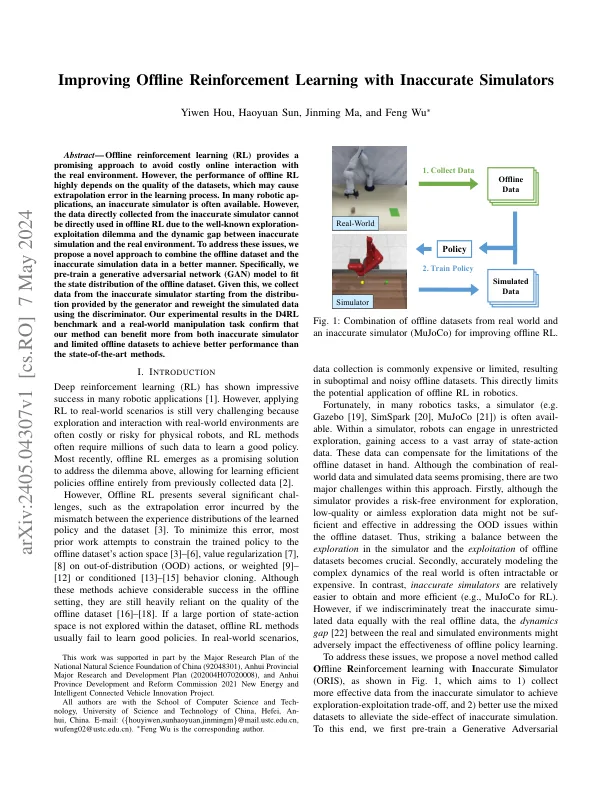

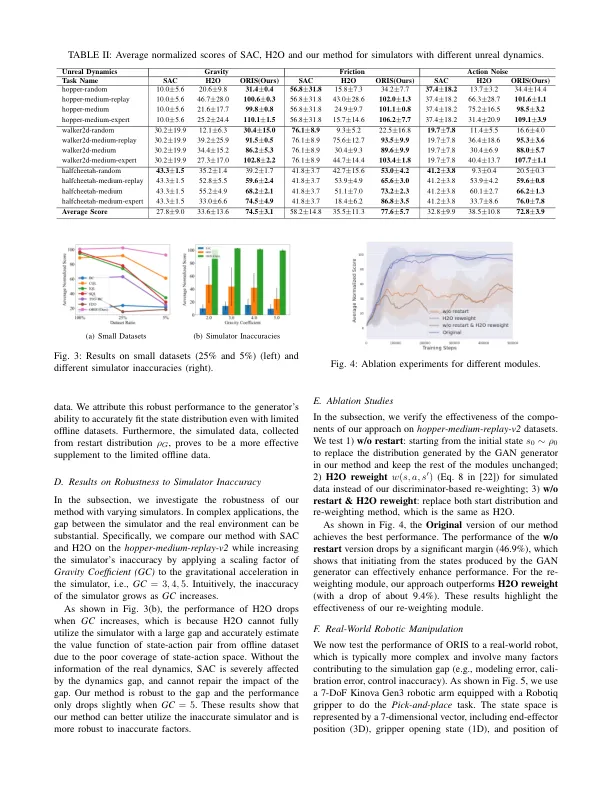

摘要 - 离线增强学习(RL)提供了一种有希望的方法,以避免与真实环境的昂贵在线互动。但是,离线RL的性能高度取决于数据集的质量,这可能会导致学习过程中的外推错误。在许多机器人范围内,通常可以使用不准确的模拟器。但是,由于众所周知的探索 - 剥削困境以及不准确的模拟和真实环境之间的动态差距,直接从不准确的模拟器收集的数据不能直接用于离线RL中。为了解决这些问题,我们提出了一种新颖的方法,以更好的方式将离线数据集和不准确的仿真数据组合在一起。具体来说,我们预先训练了生成对抗网络(GAN)模型,以适合离线数据集的状态分布。给出了这一点,我们从发电机提供的分布开始,从不准确的模拟器中收集数据,并使用鉴别器重新重量模拟数据。我们在D4RL基准测试中的实验结果和现实世界中的操纵任务确认,我们的方法可以从不准确的模拟器和有限的离线数据集中受益更多,以比先进的方法获得更好的性能。

使用不准确的模拟器改善离线增强学习

主要关键词