机构名称:

¥ 1.0

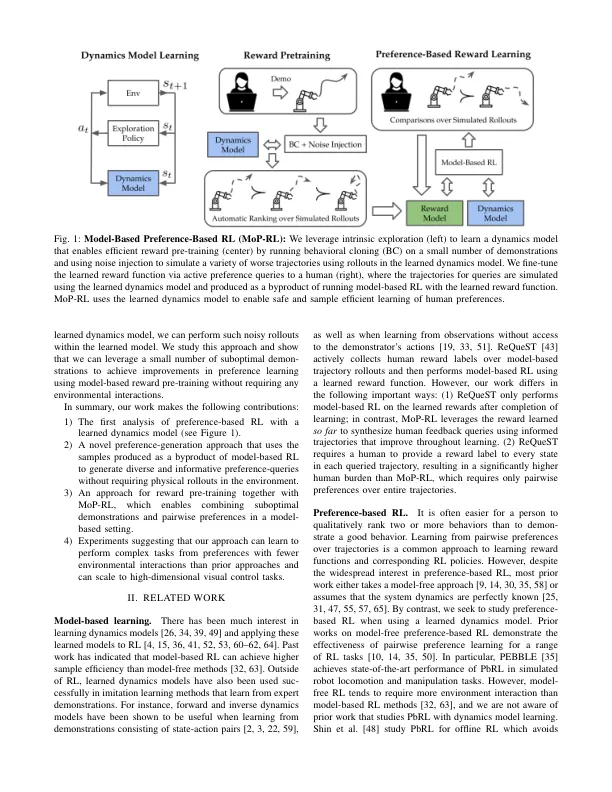

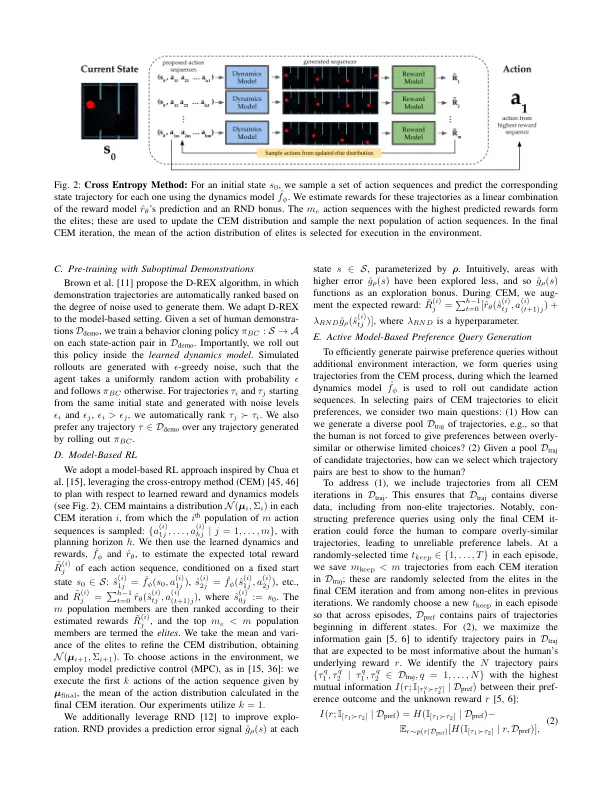

摘要 - 基于偏好的增强学习(PBRL)可以使机器人能够根据个人的喜好学习执行任务,而无需手工制作的重新功能。但是,现有方法要么假设访问高保真模拟器或分析模型,要么采用需要广泛的,可能是不安全在线环境互动的模型方法。在本文中,我们研究执行PBRL时使用学习动力学模型的好处和挑战。,我们提供的证据表明,在执行PBRL时,学到的动态模型提供了以下好处:(1)比无模型的PBRL相比,偏好启发和政策优化需要明显少于环境的互动,(2)可以在没有基于标准模型的RL和(3)奖励的范围内,无需逐步征服(2)各种偏好查询即可综合使用。 相互作用。我们的论文提供了经验证明,学到的动态模型使机器人能够以用户偏好的方式来学习自定义的策略,这些方式比先前的偏好学习方法更安全,更有效。补充材料和代码可在https://sites.google.com/berkeley.edu/mop-rl上找到。

使用学习动力学模型的有效基于偏好的增强学习

主要关键词