机构名称:

¥ 1.0

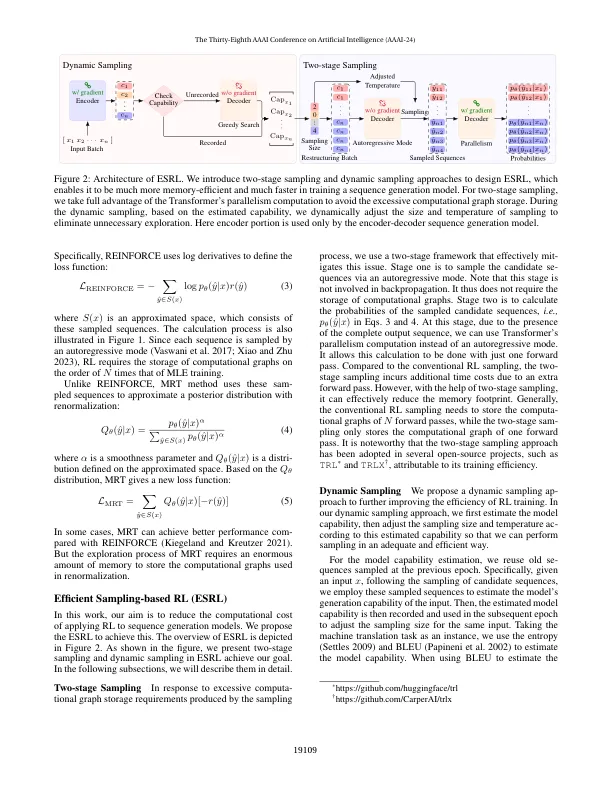

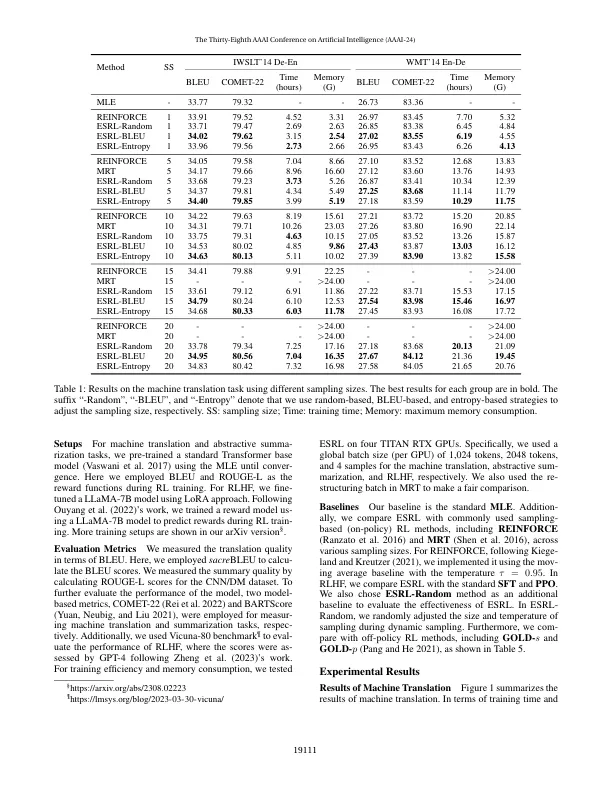

将增强学习(RL)应用于序列生成模型,可以直接优化长期校正(例如BLEU和人类反馈),但通常会在动作序列的空间序列上进行大规模抽样。这是序列产生问题(例如机器变速器)的实践所带来的计算挑战,在那里我们经常处理较大的动作空间(例如词汇表)和长长的动作序列(例如,翻译)。在这项工作中,我们引入了两阶段的采样和dy-namic抽样方法,以通过RL在训练序列产生模型期间提高采样效率。我们就传统的发电任务进行了尝试,包括机器翻译和抽象性摘要。此外,我们通过使用奖励模型训练大型语言模型来评估人类反馈(RLHF)中的RL的AP。实验结果表明,基于ASRL的有效采样的RL可以在训练效率和记忆消耗方面均超过所有基准。值得注意的是,ESRL在强大的增强,最低风险训练和近端政策优化方法上产生一致的性能。该代码可在https:// github上找到。com/wangclnlp/deepspeed-chat-extension/示例/esrl。

ESRL:序列生成的有效采样的增强学习

主要关键词