机构名称:

¥ 5.0

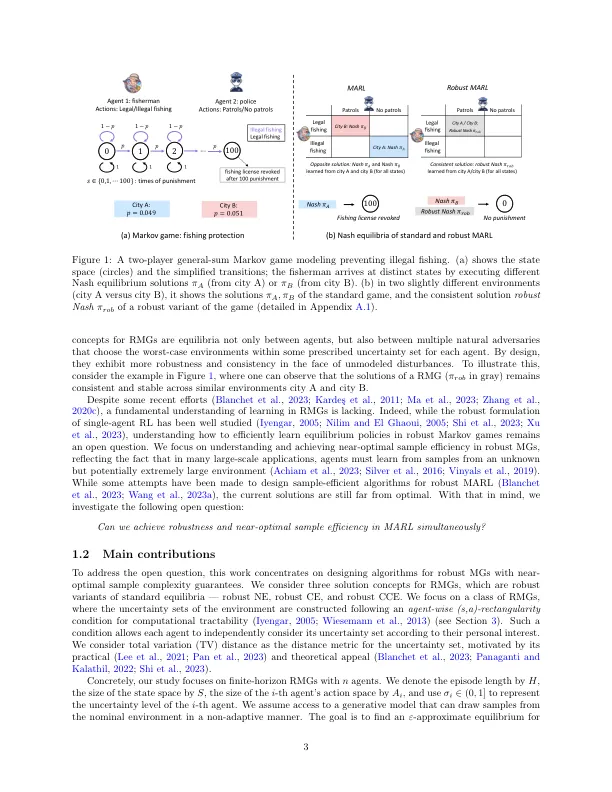

要克服加强学习中的SIM到实现差距(RL),学到的政策必须保持对环境不确定性的影响。尽管在多机构环境中,在单一机构方案中广泛研究了鲁棒的RL,但问题仍在研究中 - 尽管事实证明,环境不确定性提出的概率通常会因战略互动而加剧。这项工作着重于在分销强劲的马尔可夫游戏(RMGS)中学习,这是标准马尔可夫游戏的强大变体,其中每个代理都旨在学习一项政策,当部署的环境偏离其自身规定的不确定性不确定的不确定设置时,它最大程度地提高了自己的最差表现。这为所有与经典的游戏理论平衡概念保持一致的代理人提供了一系列强大的平衡策略。假设来自生成模型的非自适应采样机制,我们提出了一种基于样本模型的算法(DR-NVI),具有有限样本的复杂性,可保证学习游戏理论平衡的各种概念的强大变体。我们还建立了一个用于解决RMG的信息理论下限,该结合与问题相关因素(例如状态空间的大小,目标准确性和地平线长度)确定了DR-NVI的近乎最佳样本复杂性。

样本效率强大的多代理增强学习...

主要关键词