机构名称:

¥ 3.0

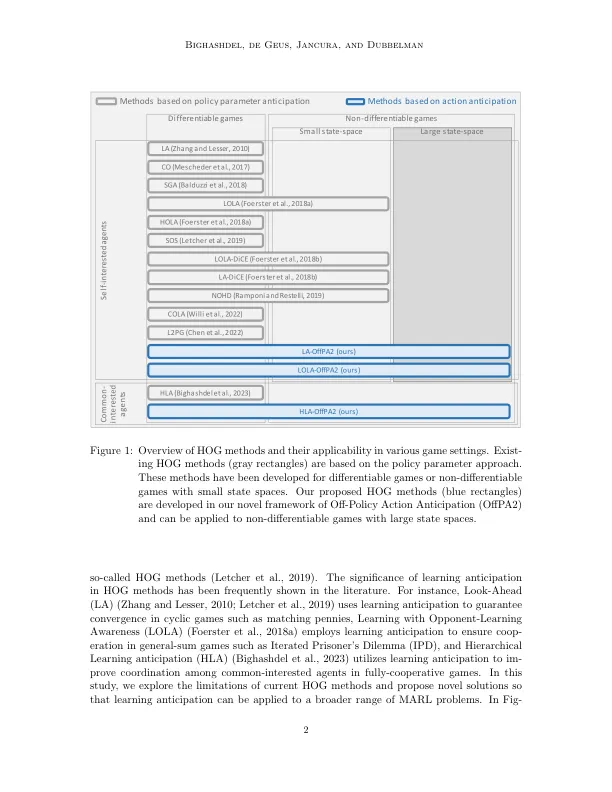

多机构增强学习(MARL)中的学习预期是一种推理范式,代理人预期了其他代理人的学习步骤,以改善彼此之间的合作。作为MARL使用基于梯度的优化,使用高阶梯度(HOG)学习预期的质量,并采用所谓的HOG方法。现有的HOG方法基于策略参数预期,即代理预测其他代理的策略参数的变化。当前,这些现有的HOG方法仅针对具有较小状态空间的可差游戏或游戏。在这项工作中,我们证明,在具有较大状态空间的非差异游戏的情况下,现有的HOG方法的性能不佳,并且由于其固有的限制与策略参数预期和多个采样阶段有关。为了克服这些问题,我们提出了O杀性策略行动预期(O效应),这是一个新颖的框架,通过行动预期来学习学习预期,即代理人通过O杀害政策采样来期待其他代理商的行动变化。我们理论上分析了我们提出的O pa2,并采用它来开发多种猪方法,这些方法适用于具有较大状态空间的非差异游戏。我们进行了大量的实验,并说明我们提出的HOG方法的表现优于现有的效率和性能。

多代理增强中的非政策行动预期...