机构名称:

¥ 1.0

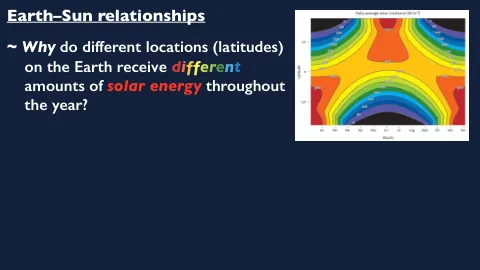

标题:数据集重置在人类反馈中的在线增强学习中的作用:从人类反馈(RLHF)学习的在线增强学习是用于微调生成模型(例如大语言模型(LLMS))的范式,例如迄今为止最强大的LLMS,例如ChatGpts和GPT4。在这项工作中,利用文本生成的关键属性 - - 在任何地方重置的能力,我们提出了一种新的专业RL算法,在RLHF Pipeline中使用时,可以超越标准RL算法(例如近端策略优化(PPO))。我们的新算法数据集重置策略梯度(DR-PG),通过数据集重置在线策略培训期间的现有离线优先数据集:它将策略梯度优化器重置给离线数据集中的州,而不是总是从初始状态分布开始。离线偏好数据集提供了更有信息的状态(即与我们要优化的基本偏好更相关),我们可以从中重置RL优化器并执行策略优化。从理论上讲,我们表明,在RLHF管道中使用DR-PG时,DR-PG学会了至少与离线数据集涵盖的任何策略一样出色。在实验中,我们证明在标准的RLHF基准中,DR-PG的一代明显好于GPT4 Win-Rate的指标下的PPO一代。Bio:Wen Sun是康奈尔计算机科学系的助理教授。在此之前,他是纽约市Microsoft Research的博士后研究员,并于2019年从卡内基·梅隆大学(Carnegie Mellon University)的机器人学院完成了博士学位。他通常对机器学习感兴趣,尤其是强化学习。他目前的许多研究都是关于设计算法,以进行有效的顺序决策,理解探索和剥削以及如何利用离线数据来克服勘探。

Wen SunWen Sun

主要关键词