机构名称:

¥ 1.0

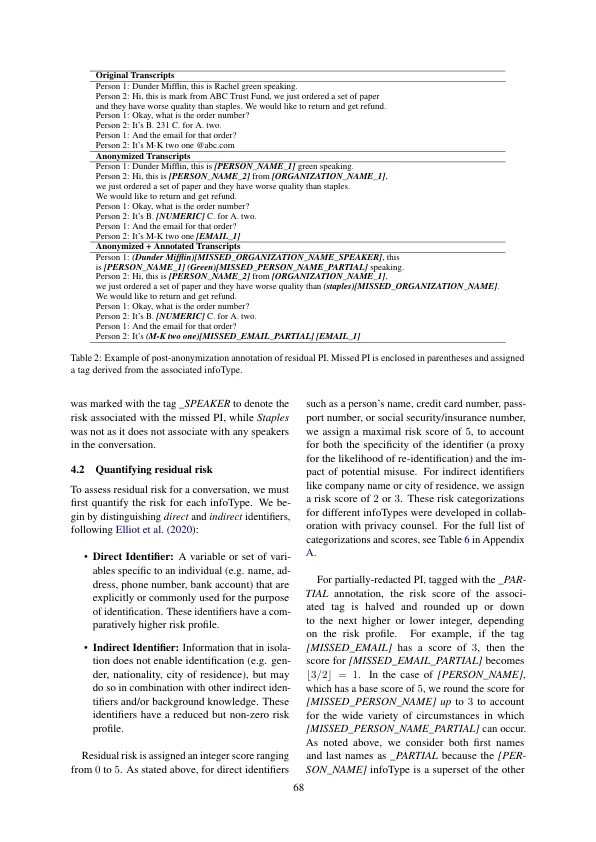

大型语言模型(LLMS)功能的最新进展(Devlin等人,2019年;布朗等人。,2020年; Zhao等。,2023年),导致了他们广泛的收养,作为工业和学术NLP各种任务的基础(Bom- Masani等人。,2021)。在数十亿和数十亿的参数计数中,这些模型需要大量的数据才能进行训练和微调(Hoffmann等人。,2022)。同时,这种过度分析能够记忆和潜在的LLMS训练数据的泄漏或提取(Biderman等人,2023; Carlini等。,2023; Hartmann等。,2023)。综上所述,LLMS所需的培训数据和记忆能力提出了实质性问题(Li等人,2023)。这种风险更加复杂,因为LLM与所有监督学习者一样,在具有与培训数据相似的分布的测试集上表现最好。因此,寻求部署实际上有效的LLM的组织必须使用反映其部署分布的数据,并使用特定的,敏感的数据(例如医疗记录或通话记录),导致绩效提高,但相应地

数据匿名用于隐私性的大语言模型在呼叫成绩单上微调

主要关键词