机构名称:

¥ 1.0

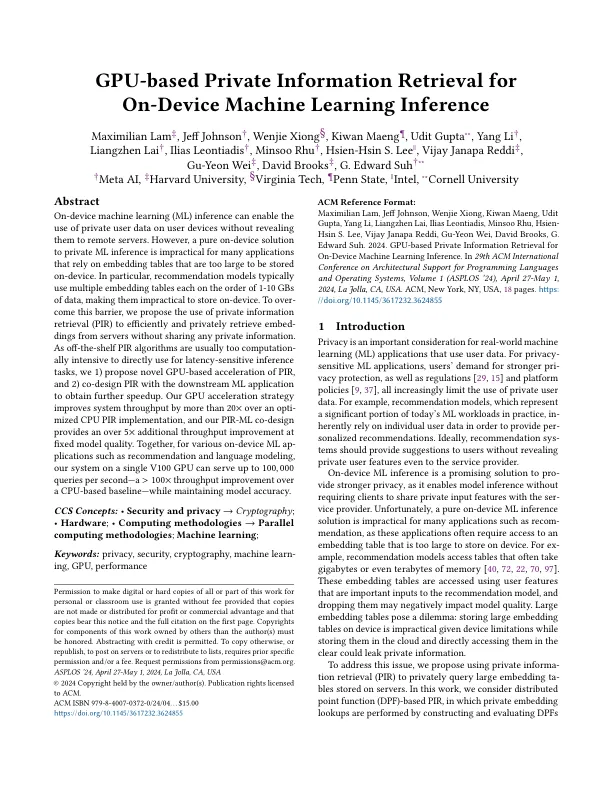

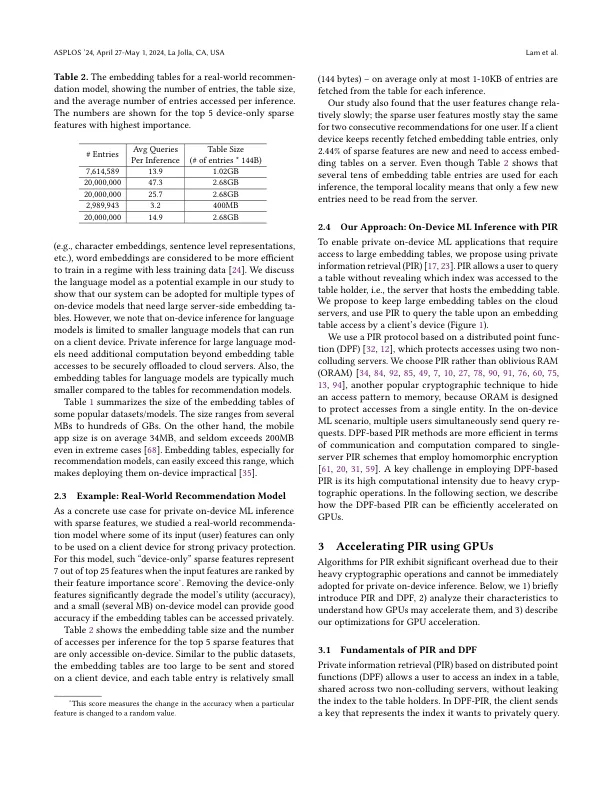

抽象的机上计算机学习(ML)推理可以在无需向远程服务器揭示的用户设备上使用私人用户数据。但是,对于依靠嵌入太大而无法存储在设备上的许多应用程序的应用程序,纯粹的私人ML推理解决方案是不切实际的。特别是,建议模型通常在1-10 GB的数据下使用多个嵌入式表,这使得它们不切实际地存储在设备上。为了超越这个障碍,我们建议使用私人信息检索(PIR)有效,私人地从服务器中嵌入嵌入,而无需共享任何私人信息。由于现成的PIR算法通常过于计算,因此很密集,无法直接用于潜伏敏感的推理任务,我们1)提出了基于GPU的新型PIR加速度,以及2)与下游ML的pir共同设计PIR,以获得进一步的加速。我们的GPU加速策略将系统吞吐量提高了20倍以上,超过了CPU PIR实现,而我们的PIR-ML共同设计在固定模型质量下提供了超过5倍的额外吞吐量改进。,对于各种设备上的ML插图,例如建议和语言建模,我们的单个V100 GPU上的系统每秒可提供高达100,000的查询 - 基于CPU的基线,A> 100×吞吐量改进 - 在基于CPU的基线上 - 维护模型准确性。

基于GPU的私人信息检索针对机上机器学习推理

主要关键词