机构名称:

¥ 1.0

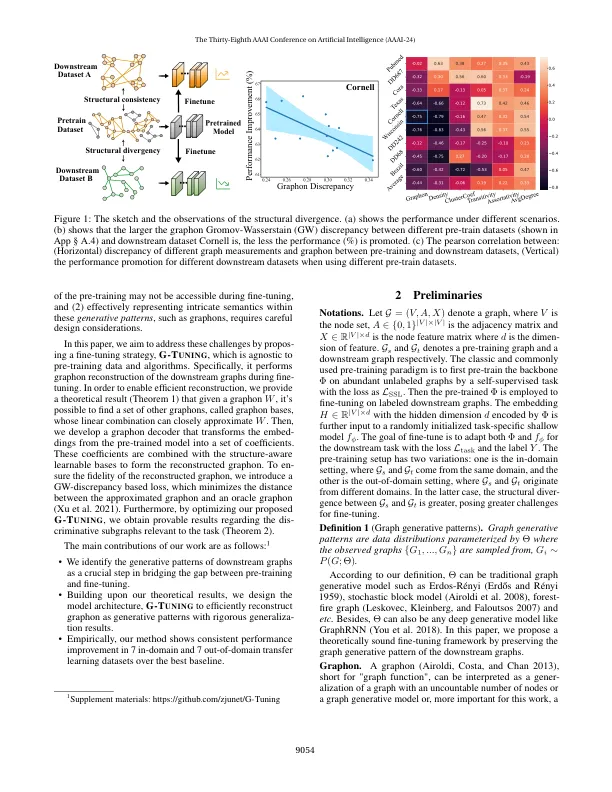

最近,在广泛的图形挖掘任务中深入研究并应用了预训练和微调图神经网络的范式。它的成功通常是对训练和下游数据集之间的结构一致性的表现,但是,在许多现实世界中,这并不成立。现有的作品表明,在使用香草微调策略时,预训练和下游图之间的结构差异显着限制了转移性。这种差异导致模型过度适应预训练图,并在捕获下游图的结构特性时造成困难。在本文中,我们将结构差异的基本原因确定为前训练和下游图之间生成模式的差异。此外,我们建议G-T Uning保留下游图的生成模式。给定下游图G,核心思想是调整预训练的GNN,以便它可以重建G graphon w的生成模式。但是,已知Graphon的确切重新构造在计算上是昂贵的。为了克服这一挑战,我们提供了一个理论分析,该分析建立了一组替代图形子的存在,称为任何给定的Graphon。通过利用这些图形碱基的线性组合,我们可以有效地近似w。这一理论发现构成了我们模型的基础,因为它可以有效地学习图形碱基及其相关系数。与现有的al-gorithm相比,G-T Uning在7个内域和7个室外转移学习实验中表现出一致的性能提高。

通过保留图生成模式

主要关键词