机构名称:

¥ 1.0

由于隐私保护,将所有数据上传到中心位置的传统机器学习方法变得不可行。联邦学习是一种保护隐私的分布式机器学习范式,已被提出作为满足隐私要求的解决方案。通过使多个客户端协作学习共享的全局模型,模型参数而不是本地私有数据将在隐私限制下交换。然而,与集中式方法相比,联邦学习在对参与者之间非独立且同分布 (non-iid) 的数据进行训练时性能会下降。在实践中,机器学习总是会遇到类别不平衡问题,这会导致对少数类的预测不佳。在这项工作中,我们提出了 FedBGVS,通过采用平衡的全局验证集来减轻类别偏差的严重程度。使用平衡全局验证分数 (BGVS) 改进了模型聚合算法。我们通过对经典基准数据集 MNIST、SVHN 和 CIFAR-10 以及公共临床数据集 ISIC-2019 进行的实验来评估我们的方法。实证结果表明,我们提出的方法在标签分布偏差和类别不平衡设置中优于最先进的联邦学习算法。

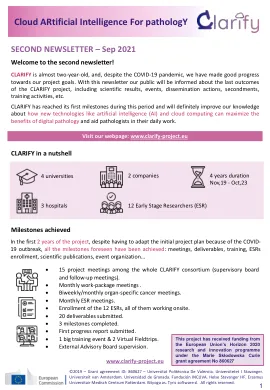

第二期简讯 – 2021 年 9 月 - CLARIFY 项目

主要关键词