XiaoMi-AI文件搜索系统

World File Search System通过分析机器学习模型中的特征子集来支持人工智能可解释性

无论是在临床研究还是风险因素计算中,机器学习算法都可以在许多医学领域中找到。这给这些算法的使用带来了重大挑战 - 特别是在伦理背景方面 - 如监管方面、可解释性或互操作性 [1]。对于这项工作,我们提出了一个关于特征贡献可解释性的特殊观点。也就是说,这不应被视为一种应用手段,而是一种更好地理解潜在问题的方法。我们的重点是人类可理解的特征子组及其各自的重要性分数的组合。特征重要性分析是机器学习模型检查和解释的主要组成部分。问题出现在解决问题的基础之上,例如在分类中,为什么对某个类别的决定是那样的。这种分析背后的方法可能因问题和模型的不同而有很大差异。我们接下来重点介绍置换重要性分析 [2]。在这里,基于测试集分析预测准确度的变化。对正在研究的特征进行置换,并将预测与未修改的特征进行比较。因此,该方法不依赖于预测过程的具体实现,因此可以应用于任何基于特征的监督机器学习模型。

可解释的AI用于使用大语言模型体系结构的网络威胁智能

对威胁的检测和理解在制定任何形式的防御策略中起着重要作用;因此,提高检测能力,以及当今网络安全性动态世界的上下文见解非常重要。本文使用大型语言模型架构来理解网络威胁智能,以解释人工智能。我们的方法利用LLM的优越NLP分析大量威胁数据,并为可能的安全风险提供可行的,可理解的见解。我们引入了一个新的范式,通过该范式将LLMS整合到经典的CTI框架中可以实现复杂的威胁模式识别,并为每个检测到的威胁提供了人类可读的解释。这将增强AI驱动威胁分析的透明度和可信度,从而使决策变得更加容易,并更加由网络安全专业人员了解。在现实世界数据集上进行了广泛的测试,以验证我们的方法,表明我们的方法显着提高了与当前方法相比的威胁检测准确性和解释质量。这些发现表明,LLMS通过将相同的相同的CTI系统嵌入到弹性和适应性方面,可以显着提高网络安全工具功效。

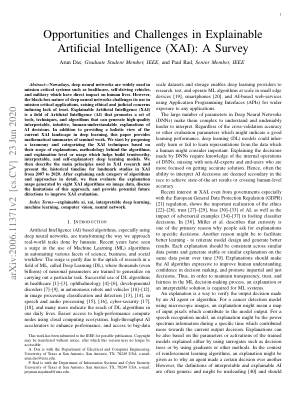

可解释人工智能的机遇与挑战......

摘要 — 如今,深度神经网络广泛应用于医疗保健、自动驾驶汽车和军事等对人类生活有直接影响的关键任务系统。然而,深度神经网络的黑箱性质对其在关键任务应用中的使用提出了挑战,引发了道德和司法问题,导致缺乏信任。可解释人工智能 (XAI) 是人工智能 (AI) 的一个领域,它推广一套工具、技术和算法,可以生成高质量、可解释、直观、人类可理解的 AI 决策解释。除了提供深度学习中当前 XAI 格局的整体视图外,本文还提供了开创性工作的数学摘要。我们首先提出一个分类法,并根据 XAI 技术的解释范围、算法背后的方法论以及解释级别或用途对其进行分类,这有助于构建可信、可解释和不言自明的深度学习模型。然后,我们描述 XAI 研究中使用的主要原理,并介绍 2007 年至 2020 年 XAI 里程碑式研究的历史时间表。在详细解释每类算法和方法之后,我们将评估八种 XAI 算法在图像数据上生成的解释图,讨论这种方法的局限性,并提供改进 XAI 评估的潜在未来方向。

机器学习模型可解释性的趋势

机器学习 (ML) 模型在医疗保健、金融和自主系统等关键领域的部署日益增多,凸显了人工智能决策对透明度和问责制的迫切需求。这促使人们越来越关注可解释人工智能 (XAI),这是一个致力于开发方法和工具的子领域,使复杂的 ML 模型可以被人类解释。本文探讨了 XAI 的主要趋势,研究了用于增强机器学习模型可解释性的理论基础和实用方法。我们全面回顾了可解释模型设计、事后可解释性技术和评估解释质量和可信度的评估指标方面的最新进展。本文还深入探讨了模型准确性和可解释性之间的权衡,以及为包括数据科学家、最终用户和监管机构在内的各种利益相关者提供有用且可理解的解释所面临的挑战。最后,我们重点介绍了 XAI 研究中的新兴方向,包括因果推理、公平性和道德考虑在可解释模型开发中的作用。通过综合当前的趋势和挑战,本文旨在更广泛地了解 XAI 的最新进展及其促进更透明、更负责和更用户友好的 AI 系统的潜力。关键词:xai、机器学习、可解释性、可解释性、公平性、敏感性、黑盒。1.介绍

可解释的人工智能可提高决策支持系统的透明度

人工智能 (AI) 被认为是一种先进的技术,可以以高精度和精确度协助决策过程。然而,由于依赖复杂的推理机制,许多 AI 模型通常被评价为黑匣子。这些 AI 模型如何以及为何做出决策的复杂性往往无法被人类用户理解,导致人们对其决策的可接受性感到担忧。先前的研究表明,缺乏以人类可理解的形式提供的相关解释会使最终用户无法接受这些决策。在这里,可解释 AI (XAI) 的研究领域提供了广泛的方法,其共同主题是研究 AI 模型如何做出决策或解释决策。这些解释方法旨在提高决策支持系统 (DSS) 的透明度,这在道路安全 (RS) 和空中交通流量管理 (ATFM) 等安全关键领域尤其重要。尽管不断发展,但 DSS 仍处于安全关键应用的发展阶段。 XAI 带来的透明度提高,成为使这些系统在实际应用中可行、解决可接受性和信任问题的关键推动因素。此外,根据欧盟委员会目前授予的解释权以及世界各地组织的类似指令,认证机构不太可能批准这些系统用于一般用途。这种将解释渗透到现行系统中的迫切愿望为以 DSS 为中心的 XAI 研究铺平了道路。

ShieldGPT:DDOS缓解的基于LLM的框架

不断发展的分布式拒绝服务(DDOS)对网络领域构成了重大威胁,该领域强调了DDOS缓解作为研究的关键领域的重要性。虽然现有的AI驱动方法(包括深神经网络作品)在检测DDOS攻击方面表现出了希望,但他们无法阐明预测理由并提供可行的缓解措施限制了其实际实用性。大型语言模型(LLMS)的出现提供了一种新颖的途径来克服这些局限性。在这项工作中,我们介绍了Shieldgpt,这是一个综合的DDOS仪式框架,可利用LLM的力量。ShieldGPT包括四个组成部分:攻击检测,流量表示,域知识注入和角色表示。为了弥合LLM的自然语言处理能力与网络流量复杂性之间的差距,我们开发了一种捕获全球和本地流量功能的表示方案。fur-hoverore,我们探索了特定于网络域的及时工程,并设计了两个迅速模板,这些模板利用了LLMS来制定特定于交通的,可理解的解释和缓解说明。我们的初步实验和案例研究验证了ShieldGPT的有效性和适用性,证明了其通过细微的见解和量身定制的策略来增强DDOS缓解工作的潜力。

对南非人对 COVID 的看法进行主题分析......

疫苗犹豫是南非和国际上的一个公共卫生问题。有关疫苗犹豫的文献将此与对政府的不信任联系起来。我们对南非 Twitter(现为 X)用户在南非推出疫苗的第一年表达的关于 COVID-19 疫苗接种的意见进行了定性分析。我们对 800 条随机选择的包含疫苗相关关键词的推文进行了主题分析,这些推文取自 2021 年的四个时间段。我们将可理解的南非非新闻推文分为支持疫苗接种(样本的 24.75%)、反对疫苗接种(20.25%)或矛盾(4.5%),然后确定主题。在支持疫苗接种的推文中,最常见的主题是对政府处理疫苗采购和推出的方式的批评;担心疫苗急需和/或无法足够快地提供;以及疫苗对 COVID-19 是安全和/或有效的声明。在反对疫苗接种的推文中,最常见的主题是声称疫苗有害或风险太大;怀疑政府向公众提供疫苗的意图;以及反对强制或“强迫”接种疫苗。支持和反对疫苗接种的推文中都存在对政府的批评和不信任,尽管原因不同。我们根据建议建立信任作为应对疫苗犹豫的文献来讨论这一点。

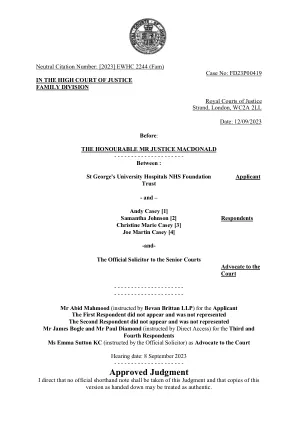

st-Georges-University-hospitals-nhs-foundation-trust-v- ...

2。按照2023年8月23日的摩尔J命令,凯西先生被加入这些诉讼的第一名被告,并被任命为诉讼朋友的正式律师。官方律师认为,在她尚未同意担任诉讼朋友的情况下,该命令无效。我接受了提交的原因,原因是我在下面的详细说明。但是,出于原因,我也将进入下面,我邀请官方律师担任法院的倡导者,她接受的邀请。官方律师指示金的律师艾玛·萨顿女士。凯西先生的母亲萨曼莎·约翰逊(Samantha Johnson)是第二被告。出于可理解的原因,她无法参加这次听证会,也没有代表。在听证会开始时,我加入了凯西先生的姐姐克里斯汀·玛丽·凯西(Christine Marie Casey)和他的兄弟乔·马丁·凯西(Joe Martin Casey),作为诉讼程序的第三和第四受访者。我听到了克里斯汀·凯西(Christine Casey)和乔·凯西(Joe Casey)的伙伴梅西·乔·菲兰(Macy Jo Phelan)的口头证据。第三和第四受访者由詹姆斯·博格尔先生和律师保罗·戴蒙德先生代表。

通过优化的深度学习模型从感觉运动大脑活动直接重建语音 Berezutskaya, Y.; Freudenburg, ZV; Vansteensel, M.

摘要 目的:脑机接口 (BCI) 技术的发展是帮助因严重运动瘫痪而失去说话能力的人实现交流的关键。一种越来越受关注的 BCI 控制策略采用从神经数据进行语音解码。最近的研究表明,直接神经记录和高级计算模型的结合可以提供有希望的结果。了解哪些解码策略可以提供最佳和直接适用的结果对于推动该领域的发展至关重要。方法:在本文中,我们优化并验证了一种解码方法,该方法基于语音重建,该语音重建直接从语音生成任务期间来自感觉运动皮层的高密度皮层脑电图记录中进行。主要结果:我们表明 (1) 专用的机器学习优化重建模型是实现最佳重建性能的关键;(2) 重建语音中的单个单词解码准确率达到 92%-100%(偶然水平为 8%);(3) 从感觉运动大脑活动直接重建可以产生可理解的语音。意义。这些结果强调了模型优化以实现最佳语音解码结果的必要性,并强调了基于感觉运动皮层重建的语音解码为开发下一代 BCI 通信技术所提供的潜力。

空中战术多代理增强学习中的解释性

人工智能(AI)在塑造未来的技术景观方面至关重要。多机构增强学习(MARL)已成为一种重要的AI技术,用于模拟各个领域的复杂动态,从而为自主代理之间的先进战略计划和协调带来了新的潜力。但是,其在敏感军事环境中的实际部署受到缺乏解释性的限制:可靠性,安全性,战略验证和人机相互作用的关键因素。本文回顾了MARL内解释性的最新进步,并提出了新颖的用例,强调了其不可或缺的检查代理决策过程。我们首先对现有技术进行了严格评估,并将其与军事策略的领域联系起来,重点是模拟空中战斗场景。然后,我们介绍了一种新型信息理论解释性描述符的概念,以分析代理人的合作能力。通过我们的研究,我们旨在强调精确理解AI决策并将这些人为产生的策略与人类理解和战略军事教义保持一致的必要性,从而提高AI系统的透明度和可靠性。通过阐明解释性在推进MARL进行操作防御方面的关键重要性,我们的工作不仅支持战略计划,而且还支持对军事人员进行洞察力和可理解的分析的培训。