机构名称:

¥ 1.0

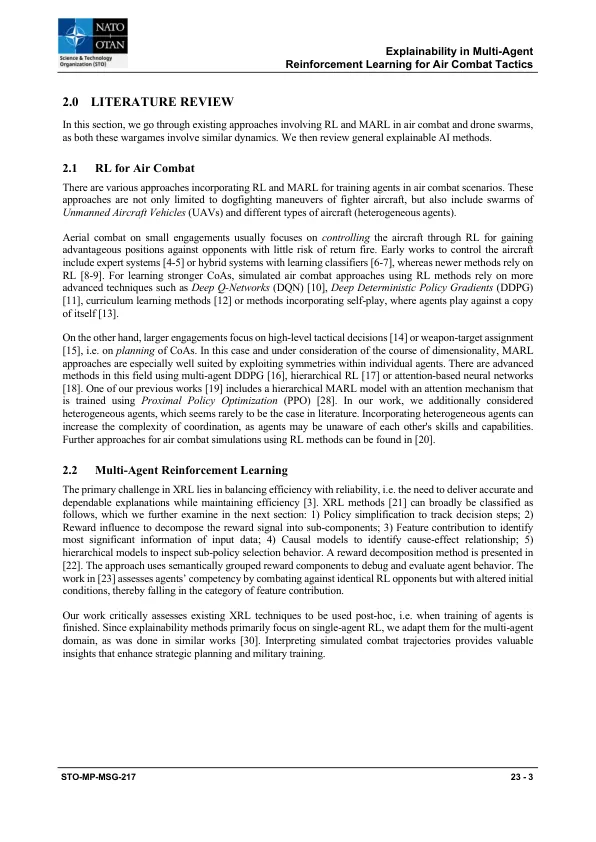

人工智能(AI)在塑造未来的技术景观方面至关重要。多机构增强学习(MARL)已成为一种重要的AI技术,用于模拟各个领域的复杂动态,从而为自主代理之间的先进战略计划和协调带来了新的潜力。但是,其在敏感军事环境中的实际部署受到缺乏解释性的限制:可靠性,安全性,战略验证和人机相互作用的关键因素。本文回顾了MARL内解释性的最新进步,并提出了新颖的用例,强调了其不可或缺的检查代理决策过程。我们首先对现有技术进行了严格评估,并将其与军事策略的领域联系起来,重点是模拟空中战斗场景。然后,我们介绍了一种新型信息理论解释性描述符的概念,以分析代理人的合作能力。通过我们的研究,我们旨在强调精确理解AI决策并将这些人为产生的策略与人类理解和战略军事教义保持一致的必要性,从而提高AI系统的透明度和可靠性。通过阐明解释性在推进MARL进行操作防御方面的关键重要性,我们的工作不仅支持战略计划,而且还支持对军事人员进行洞察力和可理解的分析的培训。

空中战术多代理增强学习中的解释性

主要关键词