XiaoMi-AI文件搜索系统

World File Search SystemAI维护:稳健性视角

摘要 — 随着机器学习 (ML) 方法和计算资源的进步,人工智能 (AI) 赋能系统正在成为一种主流技术。然而,当前的人工智能技术(例如深度学习)并非完美无缺。当缺乏可信度和透明度时,模型复杂性和数据规模的显着增加会带来更大的挑战,这可能会产生新的风险和负面影响。在本文中,我们从稳健性的角度出发,对人工智能维护进行了阐述。我们首先介绍人工智能生命周期中一些突出的稳健性挑战,并通过类比汽车维护来激励人工智能维护。然后,我们提出了一个人工智能模型检查框架来检测和减轻稳健性风险。我们还从车辆自动驾驶中汲取灵感,以定义人工智能稳健性自动化的水平。我们的 AI 维护建议有助于在整个 AI 生命周期中进行稳健性评估、状态跟踪、风险扫描、模型强化和监管,这是构建可持续和值得信赖的 AI 生态系统的重要里程碑。

流程稳健性 – PQRI 白皮书

制造工艺耐受原材料、操作条件、工艺设备、环境条件和人为因素的预期变化的能力称为稳健性。本文的目的是统一对当前工艺稳健性概念的理解以及它们如何应用于制药制造。本文还就稳健工艺的开发和维护提出了建议。这里提出的概念具有一般性,可应用于许多制造情况;然而,讨论的重点是将稳健性原则应用于非无菌固体剂型制造。本文提出的工具、案例研究和讨论围绕新产品开发和商业化展开,因为理想情况下,工艺稳健性活动从工艺设计的最早阶段开始,并贯穿产品的整个生命周期。人们还认识到,稳健性概念可以追溯应用于现有产品,以增强对工艺的理解。

稳健性验证手册 - ZVEI

2006 年底,SAE 国际汽车电子系统可靠性标准委员会和 ZVEI(德国电气电子制造商协会)成员组成联合工作组,更新 SAE 推荐实践 J1211(1978 年 11 月)“电子设备设计推荐环境实践”。J1211 的 1978 年版本是在电子设备首次引入汽车的时代编写的。人们高度关注车辆内各位置所经历的恶劣环境条件可能会对电子元件和系统的可靠性产生严重的负面影响。一些早期的发动机控制模块 (ECM) 的故障率在每百万小时 350 次故障 (f/10 6 小时)范围内,或者用客户的话来说,在车辆拥有后的前 12 个月内,发生故障的概率为 25%。当时,保修数据以 R/100(每 100 辆车的维修次数)为单位,例如 12 个月时为 25 R/100。

检测、稳健性、归因和缓解

在演讲中,我将介绍我的实验室在人工智能、应用机器学习和数据挖掘方面的最新进展,以打击网络和社交媒体平台上的恶意行为者(傀儡、逃避禁令者等)和危险内容(错误信息、仇恨等)。我的愿景是为每个人创建一个值得信赖的在线生态系统,并创建下一代促进健康、公平和安全的社会意识方法。总的来说,在我的研究中,我创建了新颖的图形、内容(NLP、多模态)和对抗性机器学习方法,利用 TB 级数据来检测、预测和缓解在线威胁。我的跨学科研究创新了社会技术解决方案,这些解决方案是我通过将计算机科学与社会科学理论相结合而实现的。我也热衷于将我的研究付诸实践——我实验室的模型已经部署在 Flipkart 上,影响了 Twitter 的 Birdwatch,现在正在部署在维基百科上。我的研究开启了范式转变,从当前缓慢而被动的应对网络危害的方法转向敏捷、主动和全社会的解决方案。我的演讲将概述我研究的四个重点:(1)跨平台、语言和模式检测有害内容和恶意行为者:我的研究超越了研究“推特上的英文文本”的标准实践,旨在解决解决跨平台(Micallef 等人,2022 年)、语言(Verma 等人,2022b 年)和模式(Verma 等人,2022b、c)(图像、视频、文本)根深蒂固的基本问题的巨大挑战。 (2) 通过预测未来的恶意活动,增强检测模型对敌对行为者的鲁棒性:我的工作是通过开发第一种对抗性学习技术来突破界限,以主动预测对手行为来欺骗检测模型。接下来,我们提高模型对操纵的鲁棒性。我的实验室调查了部署在一些最大平台上的模型的漏洞:Facebook 的 TIES 坏人检测器(He、Ahamad 和 Kumar 2021)、Twitter 的 Birdwatch 错误信息检测器(Mujumdar 和 Kumar 2021)和维基百科的禁令逃避(Niverthi、Verma 和 Kumar 2022)。(3) 归因于有害内容的影响和推荐系统的作用:我的实验室创建了数据驱动的技术来确定网络危害对

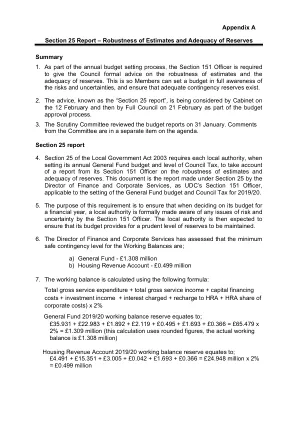

附录 A 第 25 节报告 – 估计的稳健性和……

政府正在就将于 2020/21 年实施的地方当局未来资金进行磋商;公平资金审查将根据对需求和资源的评估来评估所需的资金水平。这将与 75% 商业税保留的引入相吻合,预计我们所有的外部资金将通过调整我们的基准资金水平、关税/补足和征税来提供。还宣布新房奖金将以目前的形式停止,但预计遗留付款将继续。