XiaoMi-AI文件搜索系统

World File Search System基于ISO/IEC 42001的人工智能——管理体系构建方法

我将谈谈医疗器械开发所需的各种法规。其中一项标准就是目前流行的ISO/IEC 42001(信息技术 — 人工智能 — 管理系统),我们将讲解其内容,包括其与ISO 14971的相关性。此外,我们还将讨论《药品和医疗器械法》下的人工智能视角以及医疗器械设计和开发阶段需要注意的事项。

法律与人工智能的交汇:判断预测系统的研究趋势

Tsarapatsanis、Nikolaos Aletras、Ion Androutsopoulos 和 Prodromos Malakasiotis。2021 年。“通过正则化进行段落级理论提取:欧洲人权法院案件案例研究。”《计算语言学协会北美分会 2021 年会议论文集:人类语言技术》,226-41。在线:计算语言学协会。Chalkidis、Ilias、Abhik Jana、Dirk Hartung、Michael

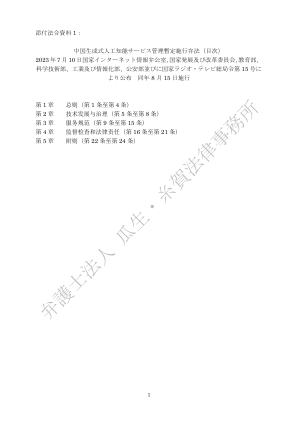

中国人工智能服务管理暂行办法2023(目录)...

第 3 章 服务规范 (第 9 条 至 第 15 条) 第 4 章 监督检查和法律责任 (第 16 条 至 第 21 条) 第 5 章 附 则 (第 22 条 至 第 24 条)

Harvey关于劳资关系和就业法 Harvey关于劳资关系和就业法

索赔人的(短)雇用于2020年9月9日终止。他于2021年2月5日提出了一周的要求,他尚未获得一周的通知工资和一部分应计假期薪酬。雇主辩称,鉴于终止日期,这已经过时了。 ET同意并驳回了索赔。但是,饮食维持了他的上诉,并允许索赔继续进行。在ET舞台上没有接听的是他的欠款工资,这意味着付款的到期日是9月18日。那是第23(2)条所设想的日期。因此,相关日期是最终付款将于9月18日到期;他于12月16日与ACAS(使用政府在线指导)联系;当早期咨询无处可去时,他于2021年1月6日获得了EC证书,然后于2月5日提交了索赔。因此,(1)他在付款日期的三个月内与ACAS联系(不是术语日期),(2)然后,他可以在1996 S 207B Q [831.02]下使用EC延长期,然后(3)他在获得EC证书的一个月内提出了他的索赔。所有这些都是及时的。

ORBYT透明度法报告ORBYT透明度法报告

2022年7月1日,《挪威透明法》已生效。目的是促进公司对商业伙伴和供应链中的基本人权和体面的工作条件的尊重。法律的重要组成部分是确保公众访问有关这些事项的信息以及公司如何处理这些问题。与其他措施一起,法律要求应为挪威的工作做出贡献,以满足并遵守联合国的可持续发展目标没有。8关于体面的工作和经济增长以及目标编号。12关于负责任的消费和生产。法律的核心需要履行和解释人权尽职调查评估的责任。人权尽职调查评估意味着,公司必须确定与生产和供应链有关的基本人权和体面的工作条件,实施改进措施,后续和报告的负面工作条件。

AI法对非歧视法和算法公平的影响

摘要AI中的公平性话题,如命运(AI)社区中的命运(公平,问责制,透明度和道德规范)所引起的,在过去几年中引发了有意义的讨论。但是,从法律的角度来看,特别是从欧盟法律的角度来看,仍然存在许多公开问题。算法公平旨在减轻设计级别的结构不平等,而欧洲非歧视法是针对部署AI模型后的个体歧视案例量身定制的。AI ACT可能会通过将非歧视责任转移到AI模型的设计阶段来弥补这两种方法迈出巨大的一步。基于对AI法案的综合阅读,我们对法律以及技术执行问题发表评论,并提出对偏见检测和偏见校正的实际含义,以指定并符合特定的技术要求。

等法机式分析仪等法机式分析仪

addorffromgtf。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。3分析。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。5分析。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。8 AnalyzeCPC2。。。。。。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>10 AnalyzitedEepSploc2。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 12分析的动物immmm。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 14 Analyzeiprepred2a。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div> 。 div>10 AnalyzitedEepSploc2。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>12分析的动物immmm。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>14 Analyzeiprepred2a。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>16个分析集和 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>20分析。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>22个分析。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>25分析帕姆。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>29分析选举。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>32分析写作 - 序列。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。。。。。。。。。。。。。。。。。。。。34创建WitchanalyPerister。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。43审查中。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。47 extractcesquencequenceenrichment。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。48 extracsquencenrichmentComparison。。。。。。。。。。。。。。。。。。。。。。。。51 extractquencequencegenome在整个环境中。。。。。。。。。。。。。。。。。。。。。。。。。。。。。53 extractcessemquencesummary。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。57 extractgeneexpression。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。59提取序列。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。61提取物。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。65提取物质量分析。。。。。。。。。。。。。。。。。。。。。。。。。。。68 eTucterSplicingGenomeome在范围内。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。70提取物。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。73提取物塑料。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。76 extractswitchoverlap。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。77 extractswitchsummary。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。79个提取物。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。。81 ImportCufflinkSfiles。。。。。。。。。。。。。。。。。。。。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>83 ImportDftf。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>。 div>87 div>

人工智能法 | 法国

虽然没有专门适用于人工智能的立法,但 2016 年 10 月 7 日颁布的 2016-1321 号法律旨在促进创新和鼓励数字经济发展,并授权法国数据保护局 (CNIL) 研究相关技术发展引发的道德问题和社会问题。自 2017 年以来,CNIL 一直积极参与确定与人工智能相关的道德和法律问题,监督涉及人工智能使用的案件,发布工具和资源以提高对人工智能的理解,并作为这一使命的一部分管理相关风险。此外,CNIL 可能会继续在法国的人工智能监管中发挥主导作用,因为法国最高行政法院建议,在欧盟人工智能法案通过后,CNIL 继续成为人工智能的主要监管机构。

人工智能法——欧盟

2021 年 4 月 21 日,欧盟委员会向欧盟共同立法者欧洲议会 (EP) 和欧盟理事会 (理事会) 提议了这项期待已久的新法规,以协调适用于欧洲内部市场的人工智能系统规则。《人工智能法案》提案的目标之一是通过一套符合欧盟价值观的人工智能开发、营销和使用的明确规则来增强内部市场的运作。为此,该提案在欧盟法律中引入了人工智能系统的技术中立定义,并采用基于风险的监管方法,每当人工智能系统可能对安全和基本权利构成高风险时,就会施加具体义务。更具体地说,这些义务是根据人工智能带来的风险水平 (最小风险、有限风险、高风险和不可接受的风险) 量身定制的。