XiaoMi-AI文件搜索系统

World File Search System事件摄像机的密集连续时间流量

摘要 - 我们提出了一种估算事件数据的密集连续时间光流的方法。传统的致密光流方法计算两个图像之间的像素位移。由于缺少信息,这些方法无法在两个图像之间的盲时间中恢复像素轨迹。在这项工作中,我们表明可以使用事件相机中的事件来计算每像素,连续的光流。事件由于其渐进性和微秒响应时间而提供了有关像素空间中运动的时间细粒信息。我们利用这些好处来通过参数化的B´ezier曲线在连续的时间内密集地预测像素轨迹。为了实现这一目标,我们构建了一个具有强大诱导偏见的神经网络:首先,我们使用事件数据及时构建了多个顺序相关量。第二,我们使用B´ezier曲线在沿轨迹的多个时间戳上为这些相关量索引。第三,我们使用检索到的相关性迭代更新B´ezier曲线表示。我们的方法可以选择包括图像对,以进一步提高性能。据我们所知,我们的模型是可以从事件数据中回归密集的像素轨迹的第一种方法。为了训练和评估我们的模型,我们引入了一个合成数据集(Multiflow),该数据集(Multiflow)具有每个像素的移动对象和地面真相轨迹。开源代码和数据集向公众发布。我们的定量实验不仅表明我们的方法在连续的时间内成功预测了像素轨迹,而且在多速和DSEC-Flow上的传统两视频像素位移中也具有竞争力。

摄像机-LLM系统的域适应技术

针对摄像机-LLM系统的域适应技术DOCAS AKINYELE,GODWIN OLAOYE日期:2024摘要:将来自相机的视觉数据与语言模型集成的视觉数据的摄像机模型(摄像头)对于各种应用至关重要,包括各种应用,包括实时图像字幕字幕,对象识别,对象识别,互动AI II系统。但是,这些系统通常由于域的变化而面临挑战 - 相机硬件的差异,环境条件和语言上下文变化。域适应技术通过使模型能够在培训和部署环境方面有效地跨不同领域执行,以解决此问题。本文探讨了与摄像机-LLM系统相关的关键领域适应技术。它涵盖了数据增强,功能一致性,对抗性训练,转移学习和生成模型。此外,它研究了这些技术如何减轻相机数据中变异性的影响并改善视觉输入和语言生成之间的交叉形态对齐。本文还讨论了诸如实时字幕,对象检测和AR/VR等应用程序,以及评估适应性绩效的评估指标。未来的方向指向多域适应性,自适应学习技术和人类在循环系统中。这些进步有望为真实应用程序提供更健壮和广义的摄像头系统。简介摄像机模型(摄像机-LLM)系统代表了视觉感知和自然语言理解的集成方面的重大进步。通过将通过相机捕获的图像数据与复杂的语言模型相结合,这些系统可实现一系列应用程序,从实时图像字幕和对象检测到交互式AI和增强现实体验。随着人工智能的能力继续增长,可以在各种环境中无缝运行的强大摄像头系统的需求变得越来越重要。

“AI起重机摄像机人体检测系统”简介

■ 简介 - 用起重机摄像机拍摄的图像 - 起重机摄像机安装在吊臂顶部并俯视地面,因此监视器上显示的人像非常小。如果操作员专注于驾驶,他们可能会忽视这一点,这是一个风险。为了充分发挥起重机摄像机的作用,我们利用基于人工智能的图像识别技术,识别起重机摄像机(监视器)上捕捉到的人和物体,并发出警报(监视器上的画面、警告音等)。开发了一种系统来检测

4MP IP AI 摄像机 - PLC-424M-AI-IR3/PM

最小值照度 0.005 lux@F1.6, AGC ON; 0 lux with IR 0.0028 lux@F1.2, AGC ON; 0 lux with IR 镜头 3.6 mm@F1.6, 水平 FoV: 80.6°; 垂直 FoV: 50.6°; 对角线 FoV:88° 调焦 固定镜头接口 M12 日夜转换 ICR 宽动态范围 120dB BLC 支持 HLC 支持 除雾 支持 数字降噪 3D DNR 角度调整 平移: 0°~360°; 倾斜:0°~80°;旋转: 0°~360° 视频压缩 Smart H.265 / H.265+ / H.265 / Smart H.264 / H.264+ / H.264 / MJPEG H.264 压缩标准 Baseline Profile/Main Profile/High Profile

CCTV摄像机准确度报告(AI分析)

闭路电视摄像机(AI分析)在比较交通量数据时准确度在±10%以内的百分比。括号内的数字表示CCTV摄像机(AI分析)的百分比,精度在±5%以内。 *不包括由于闭路电视摄像机故障等原因而未测量的部分。 *该信息的准确性是基于简单的交通量调查得出的截至 2021 年 8 月 31 日的初步值。

COTS 坚固耐用百万像素摄像机 - Alacron

图像控制和处理 RA1000 系列相机可通过其行业标准 Camera Link 接口与流行的现成图像采集卡板进行连接。通过 Adimec 与知名成像设备供应商的合作,还可以实现其他接口选项。Adimec 能够提供额外的相机功能,并为大批量项目创建客户专用相机。如需更多信息,请联系您最近的 Adimec 办事处。

3D 主动红外探测器和摄像机技术...

主动系统采用近红外脉冲激光和快速门控探测器,目前已用于大多数远程成像应用。这一概念通常称为突发照明激光雷达或 BIL。SELEX 固态探测器基于 HgCdTe 雪崩光电二极管阵列和定制设计的 CMOS 多路复用器,用于执行快速门控和光子信号捕获。这些混合阵列产生的灵敏度低至 10 个光子,这主要是由于 HgCdTe 二极管中非常高且几乎无噪声的雪崩增益。激光门控成像的优势之一是将物体从背景中分割出来,从而提供信噪比优势。然而,在复杂的场景中,在伪装和隐蔽的情况下,系统的主要增强功能是能够生成 3D 图像。在这里,探测器逐个像素地感知范围以及激光脉冲强度,为每个激光脉冲提供深度背景。 3D 数据能够更有效地从背景杂波中提取物体。距离信息受过度对比度、相干性和闪烁效应的影响较小,因此图像比传统的 2D BIL 图像更清晰。在机载应用中,拥有 3D 信息尤其有用,可以在动态环境中提供距离选通的灵活反馈控制。本报告介绍了一些可用于生成 3D 信息的探测器技术以及导致选择 SELEX 探测器的论据

Axis 摄像机监控克罗地亚的小型飞机航线。

更好地利用天线塔 OIV 通过克罗地亚的电子通信基础设施代表他人处理广播和电视节目的传输和广播。由于这一角色,该公司拥有自己的传输系统,该系统结合了微波和光纤网络。最初的想法是使用天线塔(通常位于高海拔地区,但同时方便地被网络覆盖)来帮助监测小型飞机飞行走廊的天气状况。大型商用飞机的飞行高度约为 10,000 米(私人飞机的巡航高度甚至更高,约为 12,000 米),而小型飞机的巡航高度要低得多,通常约为 500-600 米。因此,此类飞机的飞行员可以访问 4G 移动网络。这些条件成为与航空信息提供商 Croatia Control 合作的良好基础,以开发一个实时信息、图像和延时视频数据库,并在指定网站上提供给飞行员。

M31手持式热仪摄像机∎功能

Hikmicro M31手持式相机是专门设计用于温度测量的。它配备了384 x 288分辨率的热检测器。它可以帮助工作人员快速找到环境中的高温目标。同时,它为决策提供了帮助并确保安全。该设备主要应用于建筑物,HVAC,汽车行业等各种行业。

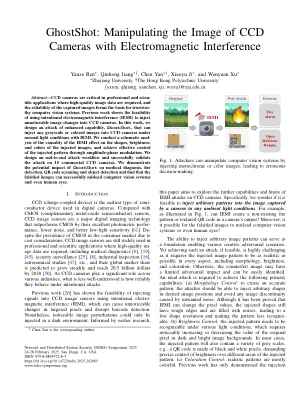

Ghostshot:用电磁干扰操纵CCD摄像机的图像

摘要 - CCCD摄像机在需要高质量图像数据的专业和专业应用中至关重要,并且捕获的图像的可靠性构成了信托计算机视觉系统的基础。先前的工作显示了使用故意电磁干扰(IEMI)将不明显的图像变化为CCD摄像机的可行性。在这项工作中,我们设计了增强功能,Ghostshot的攻击,可以在正常的光条件下使用IEMI注入任何灰度或彩色图像。我们对IEMI效应对注射图像的形状,亮度和颜色的因果关系进行了示意性分析,并通过振幅相位调制实现了对注射模式的有效控制。我们设计了端到端攻击工作流程,并成功验证了对15个商用CCD摄像机的攻击。我们证明了Ghostshot对医学诊断,火灾检测,QR码扫描和对象检测的潜在影响,并发现伪造的图像可以成功地误导计算机视觉系统,甚至是人眼。