机构名称:

¥ 1.0

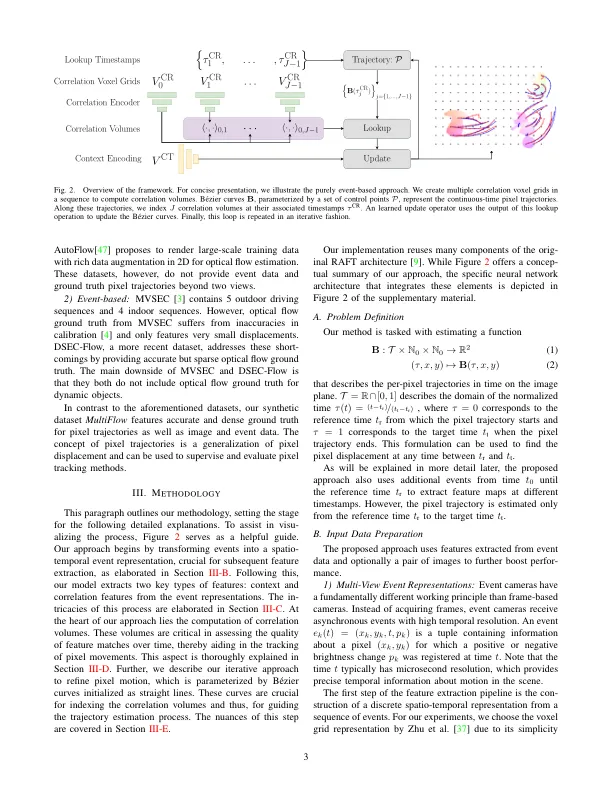

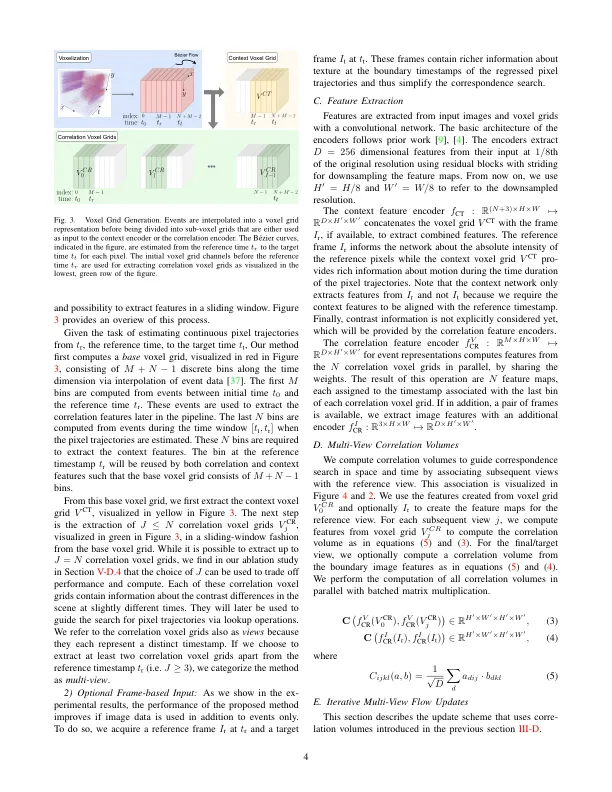

摘要 - 我们提出了一种估算事件数据的密集连续时间光流的方法。传统的致密光流方法计算两个图像之间的像素位移。由于缺少信息,这些方法无法在两个图像之间的盲时间中恢复像素轨迹。在这项工作中,我们表明可以使用事件相机中的事件来计算每像素,连续的光流。事件由于其渐进性和微秒响应时间而提供了有关像素空间中运动的时间细粒信息。我们利用这些好处来通过参数化的B´ezier曲线在连续的时间内密集地预测像素轨迹。为了实现这一目标,我们构建了一个具有强大诱导偏见的神经网络:首先,我们使用事件数据及时构建了多个顺序相关量。第二,我们使用B´ezier曲线在沿轨迹的多个时间戳上为这些相关量索引。第三,我们使用检索到的相关性迭代更新B´ezier曲线表示。我们的方法可以选择包括图像对,以进一步提高性能。据我们所知,我们的模型是可以从事件数据中回归密集的像素轨迹的第一种方法。为了训练和评估我们的模型,我们引入了一个合成数据集(Multiflow),该数据集(Multiflow)具有每个像素的移动对象和地面真相轨迹。开源代码和数据集向公众发布。我们的定量实验不仅表明我们的方法在连续的时间内成功预测了像素轨迹,而且在多速和DSEC-Flow上的传统两视频像素位移中也具有竞争力。

事件摄像机的密集连续时间流量

主要关键词