XiaoMi-AI文件搜索系统

World File Search Systemphanaki:可变长度视频生成

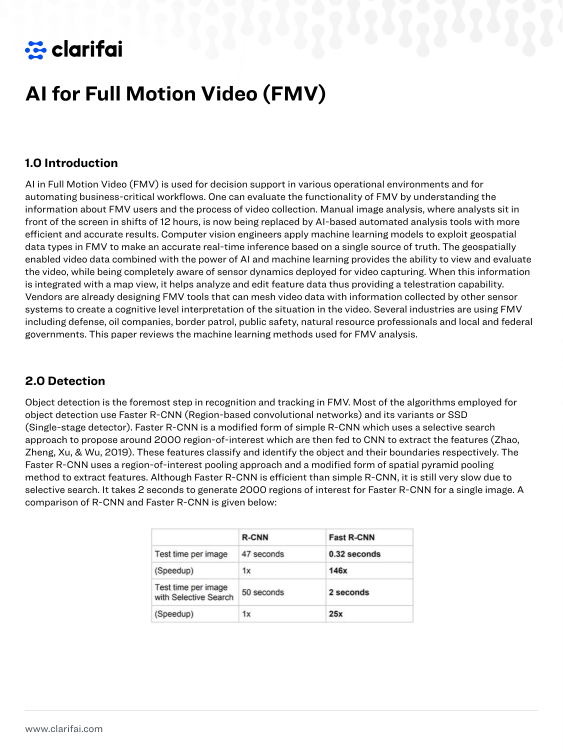

我们提出了一个能够实现现实视频综合的模型,给定一系列文本提示。由于计算成本,数量有限的高质量文本视频数据和视频长度的变化,因此从文本中生成视频尤其具有挑战性。为了解决这些问题,我们介绍了一种新的模型,以学习视频表示,该模型将视频压缩为一小部分离散令牌。这个令牌仪会及时使用因果关注,这使其可以与可变长度视频一起使用。为了从文本生成视频令牌,我们使用的是在预先计算的文本令牌上进行的双向蒙版变压器。随后对生成的视频令牌进行了解密以创建实际的视频。为了解决数据问题,我们演示了大量图像文本对的联合培训以及少量的视频文本示例如何导致概括超出视频数据集中的可用内容。与以前的视频生成方法相比,Phanaki可以生成以一系列提示为条件的任意长视频(即时间变量文本或故事)在开放域中。据我们所知,这是第一次研究从开放域时间变量提示中生成视频的论文。此外,与每个框架基线相结合,所提出的视频编码器计算每个视频的代币较少,但会导致更好的时空一致性。

基于人工智能深度学习的视频分析 - ...

除了缺乏视频分析来充分利用闭路电视摄像机捕获的信息之外,传统的实施还依赖于有线信号传输,这增加了成本,限制了可扩展性,并且使得在许多地方安装不切实际。相比之下,DeepSight 平台利用 5G 网络基础设施构建高度可扩展且稳定的视频分析解决方案,可以实时处理来自数千台摄像机的实时信息,充分利用 5G 在高带宽、低延迟和增强安全性方面的进步。DeepSight 平台旨在改装到现有实施中,它支持任何闭路电视摄像机,5G 可以覆盖的任何地方,包括偏远地区和机载无人机。基于云的深度学习使实施能够扩展到数千台闭路电视摄像机甚至更多,同时实施可以涵盖许多行业、终端设备和功能,如图 2 所示。

来自单眼视频的高保真头发建模

毫无疑问,高保真3D头发对于实现现实,艺术表达和沉浸在计算机图形中至关重要。现有的3D头发建模方法取得了令人印象深刻的性能,但实现高质量头发重建的挑战仍然存在:它们要么重新确定严格的捕获条件,因此很难实现实践应用,或者很大程度上依赖于学到的先前数据,并在图像中遵守细节细节。为了应对这些挑战,我们提出了Monohair,这是一个通用框架,以从单元视频中实现高保真的头发重建,而对环境没有具体要求。我们的方法将头发建模过程分为两个主要阶段:精确的外部重建和内部结构推断。使用基于补丁的多视图优化(PMVO)精心制作外部。此方法从策略性地收集并集成了从多个视图(独立于先前数据)产生高保真外部3D线图的头发插入。此地图

3D多帧融合视频稳定

在本文中,我们提出了RSTAB,这是视频稳定框架的新型框架,该框架通过音量渲染整合了3D多帧融合。与传统方法背道而驰,我们引入了一个3D多框架透视图,以进行稳定的图像,从而解决了全框架生成的挑战,同时保存结构。我们的RSTAB框架的核心在于S Tabilized R Endering(SR),该卷渲染模块,在3D空间中融合了多帧信息。具体来说,SR涉及通过投影从多个帧中旋转的特征和颜色,将它们融合到描述符中以呈现稳定的图像。然而,扭曲的信息的精度取决于降低的准确性,这是受染色体区域显着影响的因素。为了响应,我们介绍了a daptive r ay r ange(arr)模块以整合深度先验,并自适应地定义了投影过程的采样范围。在方面上,我们提出了以光流的光流限制的限制,以进行精确的颜色,以实现精确的颜色。多亏了这三个模块,我们的rstab示例表现出了卓越的性能,与以前的视野(FOV),图像质量和视频稳定性相比,各种数据集的稳定器相比。

基于视频的自闭症检测深度学习

摘要 - 自闭症谱系障碍(ASD)的个人经常在健康,沟通和疾病处理中面临挑战;因此,早期诊断对于适当的治疗和护理是必需的。在这项工作中,我们考虑了检测或分类ASD儿童以帮助医疗专业人员早期诊断的问题。我们开发了一个深度学习模型,该模型分析了儿童对感觉刺激的反应的视频片段,目的是捕获ASD和非ASD参与者之间反应和行为的关键差异。与MRI数据的许多最近的ASD分类研究不同,它需要昂贵的专用设备,我们的方法使用了功能强大但相对便宜的GPU,标准的计算机设置和摄像机进行推理。结果表明,我们的模型有效地概括并理解儿童不同运动的关键差异。值得注意的是,尽管对于深度学习问题的数据有限,并且即使使用运动伪像,但我们的模型仍表现出成功的分类性能。索引术语 - 深度学习,自闭症谱系障碍,视频,分类

不需要翻译四十年的视频和...

第一个视频节日于1983年在圣保罗举行。这是一个越来越多信心其在世界文化地图上的地位的国家中的年轻艺术展示。从一开始,Videobrasil为来自所谓的全球南方的艺术家和电影制片人提供了一个特殊的位置。一个新时代正在介绍,作为替代的地缘政治杆,以将世界的旧分裂替换为社会主义和资本主义营地。节日一直对世界地图(东亚,非洲,东欧,东欧)上的那些地方最感兴趣,那里的生活迅速变化,就像在拉丁美洲一样。随着时间的流逝,这种兴趣导致了一个主要的机构AssociaçãoCulturalVideobrasil的出现,该视频致力于展示,归档,流行和研究非传统形式的屏幕文化。

4/16 通道网络视频编码器

产品、配件或文献上的此标记表示产品及其电子配件(例如充电器、耳机、USB 线)在使用寿命结束时不应与其他家庭垃圾一起处理。为防止不受控制的废物处理对环境或人类健康造成可能危害,请将这些物品与其他类型的废物分开,并负责任地回收,以促进材料资源的可持续再利用。

将视频理解 AI 提升到新水平

Twelve Labs 使用多模态视频语言基础模型来捕获视频的完整语义和上下文内容——这意味着捕获的语义和上下文内容存储在称为“嵌入”的矢量表示中,然后实现对视频的人类层面的理解。媒体服务平台 VidiNet 和 Twelve Labs 产品的集成提供了一种解决方案,使手动记录和元数据生成变得过时。将 Twelve Labs 的视频语言基础模型集成到直观的用户界面 MediaPortal 中,改变了用户搜索资料的方式,因为它无需在核心服务 Vidi-Core 中索引所有静态元数据字段。用户现在可以使用自然语言查询精确定位视频档案中的特定时刻,并与 VidiNet 索引的元数据无缝合并。但这到底意味着什么呢?用户现在可以使用自然语言查询在他们的视频中找到确切的时刻,并将它们与来自 Vidispine 应用程序的元数据相结合。