机构名称:

¥ 1.0

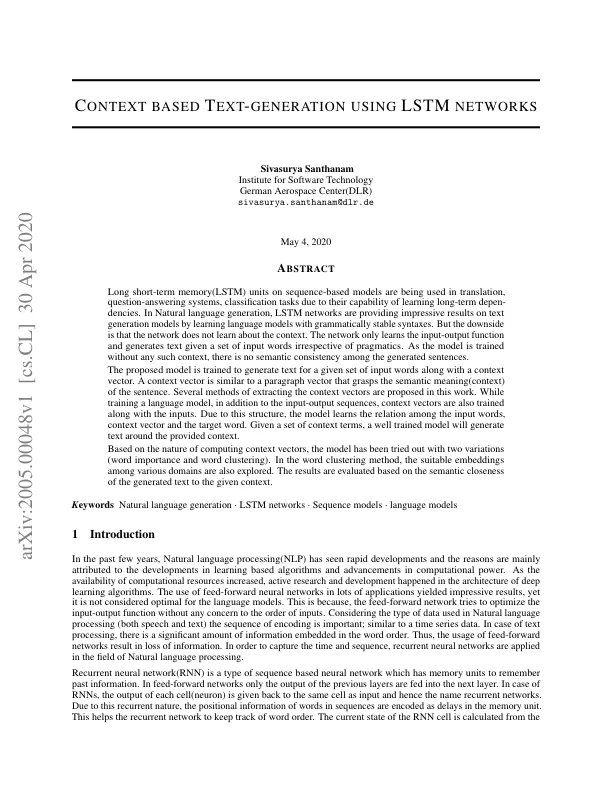

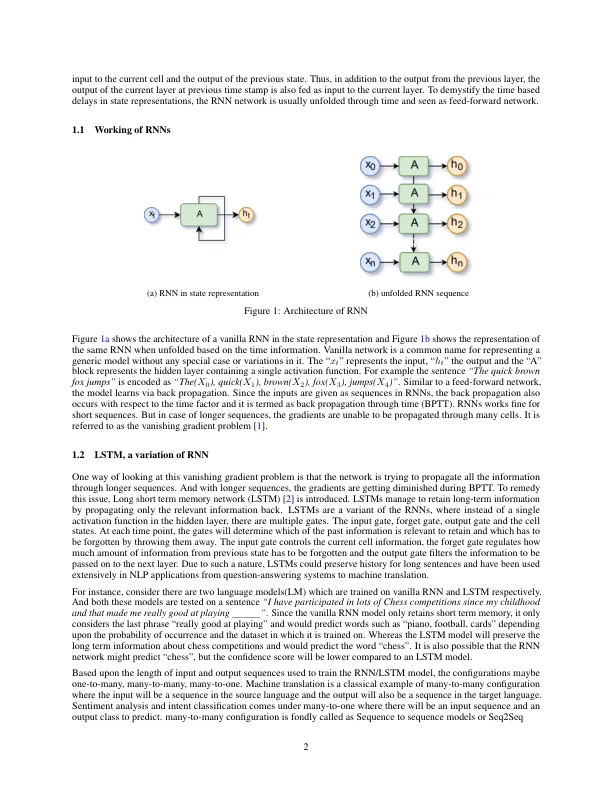

基于序列的模型上的长短期记忆 (LSTM) 单元因其学习长期依赖关系的能力而被用于翻译、问答系统和分类任务。在自然语言生成中,LSTM 网络通过学习具有语法稳定的句法的语言模型,在文本生成模型上提供了令人印象深刻的结果。但缺点是网络不会学习上下文。网络只学习输入输出函数,并根据一组输入词生成文本,而不考虑语用。由于模型是在没有任何此类上下文的情况下训练的,因此生成的句子之间没有语义一致性。所提出的模型经过训练,可为给定的一组输入词生成文本以及上下文向量。上下文向量类似于段落向量,它掌握句子的语义(上下文)。本文提出了几种提取上下文向量的方法。在训练语言模型时,除了输入输出序列之外,还会与输入一起训练上下文向量。由于这种结构,模型可以学习输入词、上下文向量和目标词之间的关系。给定一组上下文术语,训练有素的模型将围绕提供的上下文生成文本。基于计算上下文向量的性质,该模型已尝试了两种变体(单词重要性和单词聚类)。在单词聚类方法中,还探索了各个领域之间的合适嵌入。根据生成的文本与给定上下文的语义接近度来评估结果。

使用 LSTM 网络进行基于上下文的文本生成