机构名称:

¥ 1.0

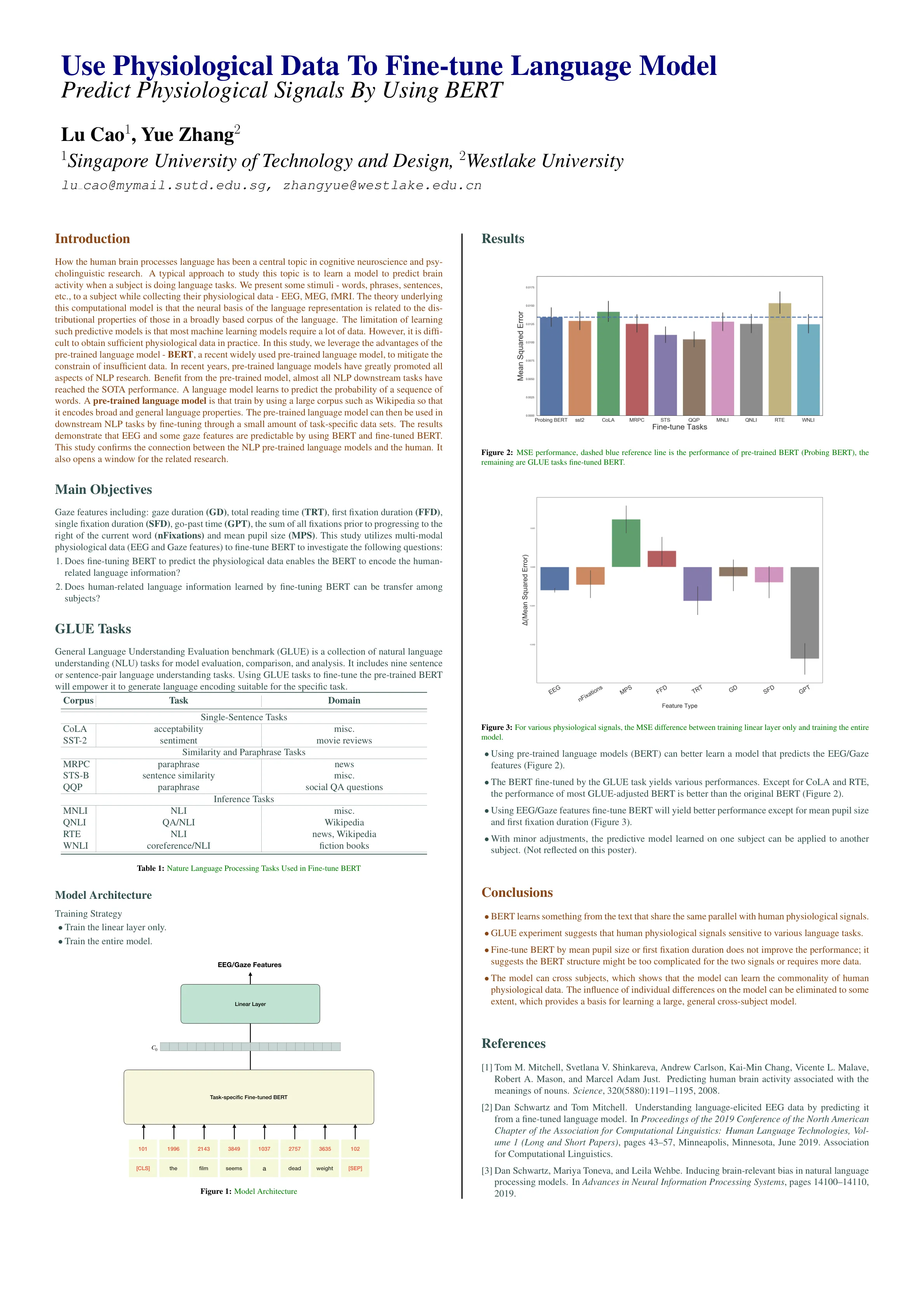

人类大脑如何处理语言一直是认知神经科学和心理语言学研究的中心课题。研究这个课题的典型方法是学习一个模型来预测受试者在做语言任务时的大脑活动。我们给受试者提供一些刺激——单词、短语、句子等,同时收集他们的生理数据——EEG、MEG、fMRI。这个计算模型背后的理论是语言表征的神经基础与广泛的语言语料库中神经表征的分布特性有关。学习这类预测模型的局限性在于大多数机器学习模型都需要大量数据。然而,在实践中很难获得足够的生理数据。在本研究中,我们利用预训练语言模型——BERT(一种近期广泛使用的预训练语言模型)的优势来缓解数据不足的限制。近年来,预训练语言模型极大地促进了NLP研究的各个方面。得益于预训练模型,几乎所有的NLP下游任务都达到了SOTA性能。语言模型学习预测单词序列的概率。预训练语言模型是使用大型语料库(例如Wikipedia)进行训练,从而编码广泛而一般的语言属性。然后可以通过少量特定于任务的数据集对预训练语言模型进行微调,将其用于下游NLP任务。结果表明,使用BERT和微调后的BERT可以预测EEG和一些凝视特征。这项研究证实了NLP预训练语言模型与人类之间的联系。它也为相关研究打开了一扇窗户。

使用 BERT 预测生理信号

主要关键词