机构名称:

¥ 1.0

利用置信度分数的一个关键挑战是,当提示提供置信度分数时,LLM 会表现出过度自信。Wei 等人(2024) 在他们的 SimpleQA 基准中证明了这种现象,观察到各种前沿 LLM(包括 GPT-4 和 Claude)都存在一致的过度自信。这种固有的局限性强调了仔细解释 LLM 生成的置信度分数的必要性。直接使用原始置信度分数作为人工审查的阈值可能不是最佳选择。Wei 等人(2024) 还发现,利用 LLM 的随机性来确定置信度作为答案频率的衡量标准可以改善校准,特别是对于较大的前沿模型,但除了 01-preview 之外,仍然表现出过度自信。值得注意的是,两种方法都表现出近似单调的关系,这可能表明重新校准是产生校准概率的潜在途径。

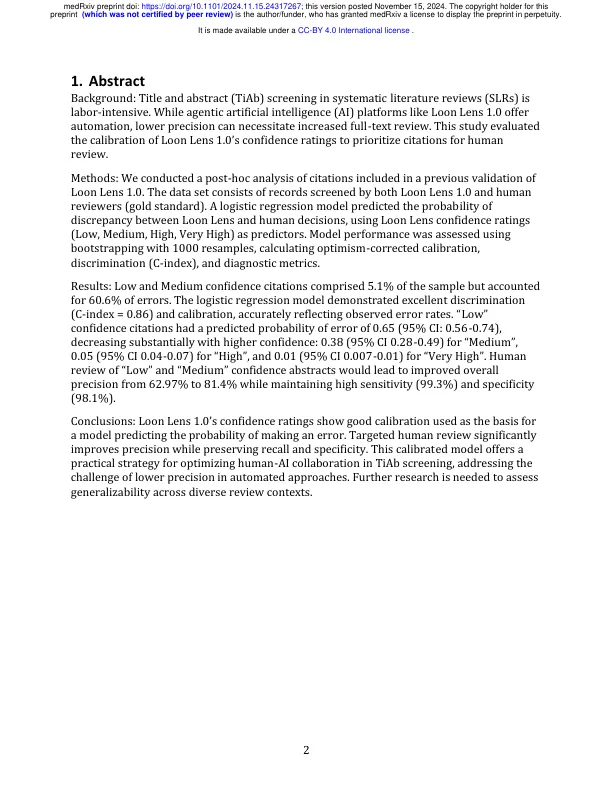

用于简化标题和摘要筛选的代理 AI