机构名称:

¥ 1.0

根据目标问题,最佳 ML 模型和支持生命周期 (E4) 的复杂性可能会有很大差异。对于较简单的问题,线性回归、较小的决策树和具有少量节点和层的简单神经网络 (NN) 就足够了。对于更复杂的问题,可能需要具有许多层和节点以及多个卷积层的大型决策树或深度神经网络 (DNN) 来实现所需的准确性。用于控制优化目标的 RL 方法和支持代理 (E7) 在学习新颖的 RAN 管理策略方面尤其有效。训练 RL 模型依赖于通过软件代理的反复试验进行主动探索,这在实时 RAN 系统中并不总是可行或合适的。为了帮助解决这个问题,并生成训练模型所需的数据量,我们在我们的软件推动器集中包含了模拟 (E6)。经过训练后,ML 模型可用于推理阶段(E3 的一部分),其中选择的数据被用作模型的输入,然后模型将产生一组预测、操作或规则,具体细节取决于 ML 算法类型。在 RAN 中,训练和推理阶段的硬件和软件要求可能大不相同。训练通常需要强大的中央处理单元或专用图形处理单元 (GPU) 硬件,具有大内存和数据存储。AI 软件平台(例如 TensorFlow、Keras 和 PyTorch)以及其他广泛的开源(E5)、通常基于 Python 的 ML 软件生态系统需要集成到软件工程流程中。在推理阶段,通过模型生命周期管理 (E4) 向 RAN 应用程序提供经过训练的模型(或多个模型)。对于延迟至关重要的 RAN 边缘应用,需要高效实现推理,具有低延迟、低功耗和内存占用,同时考虑目标硬件和软件架构的特性。我们的软件推动器与基于意图的管理解决方案完全兼容 [5]。

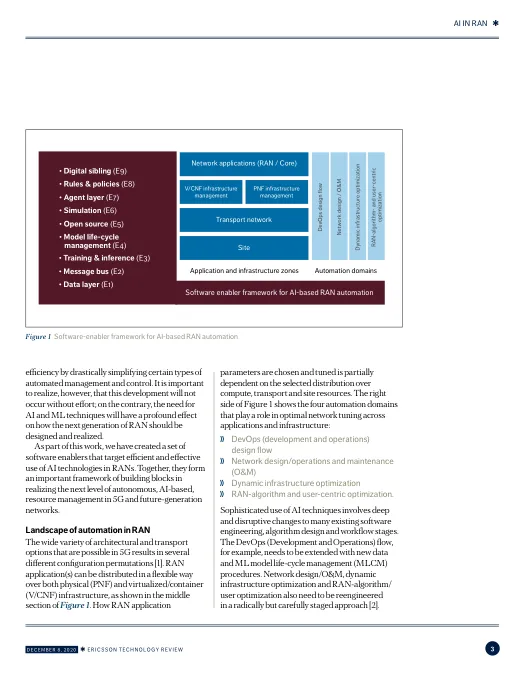

RAN 中的人工智能