机构名称:

¥ 1.0

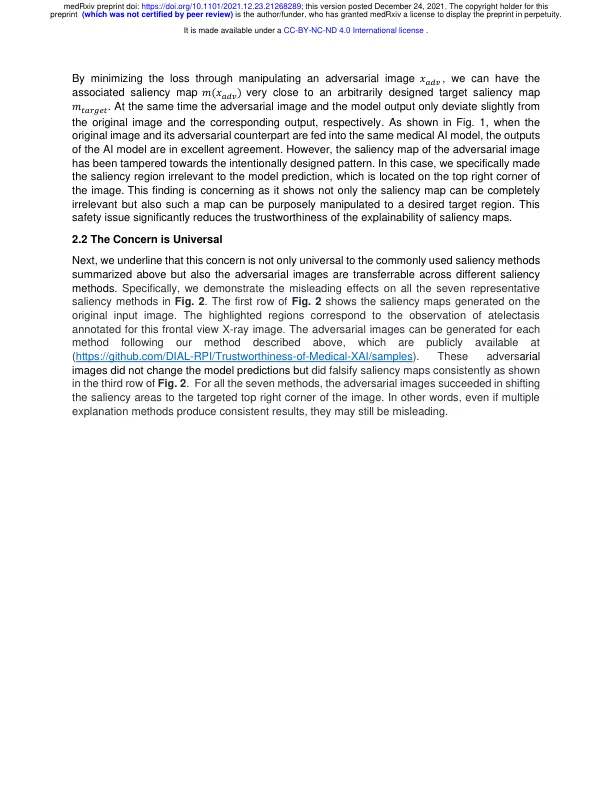

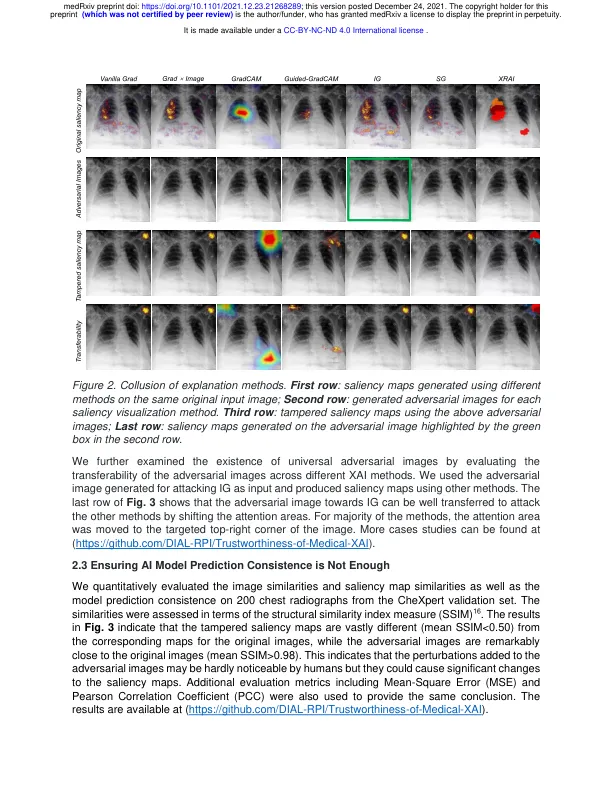

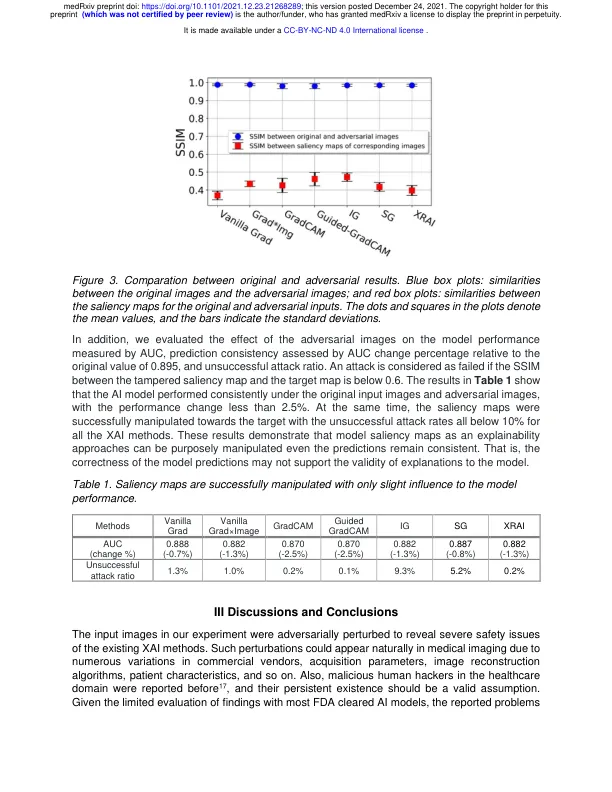

虽然已经提出了各种方法来解释人工智能模型,但对生成的解释的可信度却很少进行检验。本文表明,这种解释可能容易受到输入的细微扰动的影响,并产生误导性结果。在公共 CheXpert 数据集上,我们证明专门设计的对抗性扰动可以很容易地篡改显着性图以达到所需的解释,同时保留原始模型预测。医学领域的人工智能研究人员、从业者和权威机构在解释人工智能模型时应谨慎,因为这种解释可能不相关、误导,甚至在不改变模型输出的情况下被对抗性操纵。医学领域的人工智能研究人员、从业者和权威机构在解释人工智能模型时应谨慎,因为这种解释可能不相关、误导,甚至在不改变模型输出的情况下被对抗性操纵。

医疗 AI 中可解释性的可信度被忽视