机构名称:

¥ 1.0

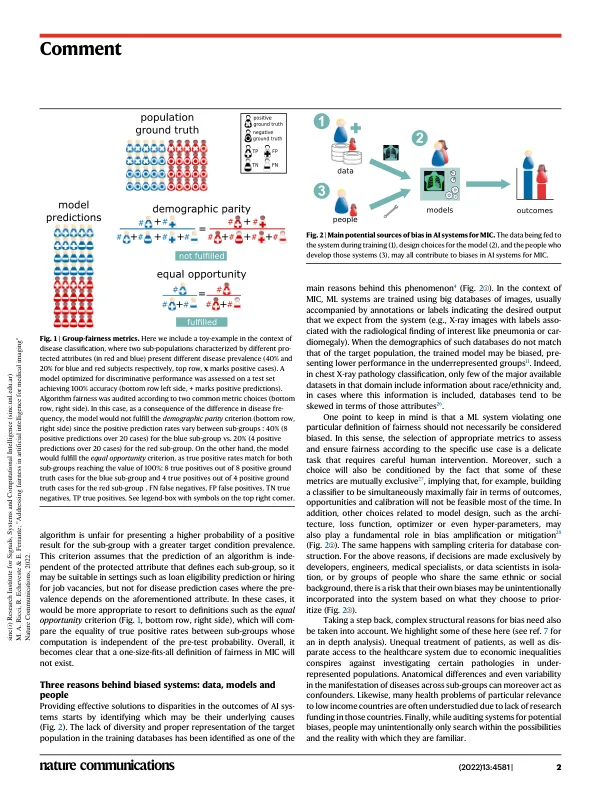

随着用于医学图像分析的人工智能 (AI) 系统的发展呈指数级增长,医院和医疗中心已开始在临床实践中部署此类工具 1 。这些系统通常由一种称为深度学习 (DL) 的特定类型的机器学习 (ML) 技术提供支持。DL 方法通过采用具有不同抽象级别的多层处理来学习复杂的数据表示,这对于解决广泛的任务很有用。在医学图像计算 (MIC) 背景下,此类任务的示例包括病理分类、解剖分割、病变描绘、图像重建、合成、配准和超分辨率等 2 。虽然与在实验室条件下应用于不同 MIC 问题的 DL 方法相关的科学出版物数量呈指数级增长,但旨在评估医疗 AI 系统的临床试验最近才开始获得发展势头。事实上,根据美国放射学会的数据,迄今为止,美国食品药品监督管理局 (FDA) 批准的与放射学和其他成像领域相关的 AI 医疗产品不到 200 种 3 。最近,机器学习公平性研究界强调,机器学习系统可能会对某些亚群体产生偏见,即它们对不同亚群体表现出不同的表现,这些亚群体由年龄、种族/民族、性别、社会经济地位等受保护属性定义 4、5 。在医疗保健领域,算法对不同人群亚群体的潜在不平等行为甚至可能被认为违背了生物伦理学原则:正义、自主、仁慈和非男性原则 6 。在这种背景下,促进 MIC 的公平性变得至关重要。然而,这绝非易事:确保机器学习部署的公平性需要解决整个设计、开发和实施过程中的多个不同方面。虽然机器学习公平性对

解决医学成像人工智能的公平性问题

主要关键词