机构名称:

¥ 1.0

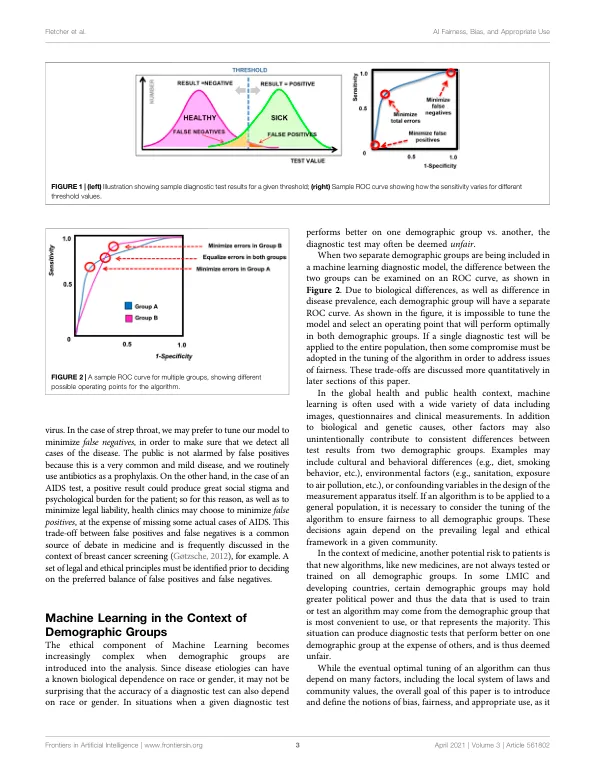

在中低收入国家 (LMIC),机器学习 (ML) 和人工智能 (AI) 为解决医疗资源短缺和提高当地医疗基础设施能力提供了有吸引力的解决方案。但是,AI 和 ML 也应谨慎使用,因为如果应用不当,可能会出现公平性和算法偏见问题。此外,由于缺乏技术能力、存在针对少数群体的社会偏见以及缺乏法律保护,中低收入国家的人群特别容易受到人工智能算法的偏见和公平性的影响。为了满足在全球卫生背景下更好指导的需求,我们描述了三个基本标准(适当性、公平性和偏见),可用于帮助评估机器学习和人工智能系统的使用情况:1)适当性是决定如何在本地环境中使用算法的过程,并将机器学习模型与目标人群正确匹配; 2) 偏见是模型中偏向某一人口群体而偏向另一群体的系统性倾向,这种倾向可以减轻,但会导致不公平;3) 公平涉及研究对不同人口群体的影响,并从几种群体公平的数学定义中选择一个,以充分满足所需的法律、文化和道德要求。最后,我们通过一个机器学习应用于印度浦那肺部疾病诊断和筛查的案例研究,说明了如何应用这些原则。我们希望这些方法和原则能够帮助指导正在考虑使用机器学习和人工智能的全球卫生研究人员和组织。

解决公平性、偏见和人工智能的适当使用问题……

主要关键词