机构名称:

¥ 1.0

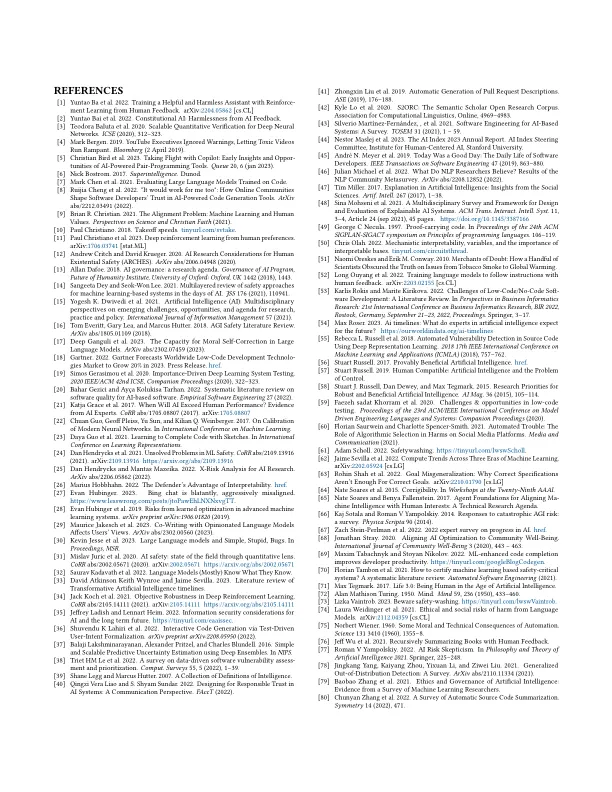

数据驱动技术的兴起推动了人工智能 (AI) 的快速发展。自 2010 年以来,用于训练最大 AI 模型的计算能力大约每 6 个月翻一番 [62]。私人对人工智能的总投资是十年前的 10 倍多 [44]。软件工程 (SE) 研究人员越来越多地关注并为这一进步做出贡献。在审查 2022 年大型 SE 会场 1 上的论文时,我们估计有 33% 的论文在标题或摘要 2 中提到了 AI/ML/DL 术语。相比之下,2012 年这一比例为 4%。软件工程人工智能 (AI4SE) 和人工智能软件工程 (SE4AI) 的兴起要求 AI 安全成为 SE 研究人员关注的问题。人工智能安全是指避免受到人工智能的伤害。我们赞同以下论点:这里最紧迫的考虑是极限安全,即当人工智能开始在所有领域匹敌或超越人类能力时的安全性。此类系统的集合被称为高级机器智能 (HLMI) [ 21 ],类似于通用人工智能 (AGI) 或变革性人工智能 (TAI) 等概念。HLMI 安全性方面无法取得进展可能会带来灾难性的后果,包括人类的灭绝。SE 研究人员在加剧危险或帮助降低风险方面可以发挥作用。我们将讨论原因,并提供类似于现有 SE 问题的具体 AI 问题的有用概念。我们认为,尽管 AI4SE 工作有所增加,但高度先进的 AI 的安全影响在 SE 会议上很少被讨论。我们通过引用图来探索这一假设

软件工程研究人员的人工智能安全子问题

主要关键词