机构名称:

¥ 1.0

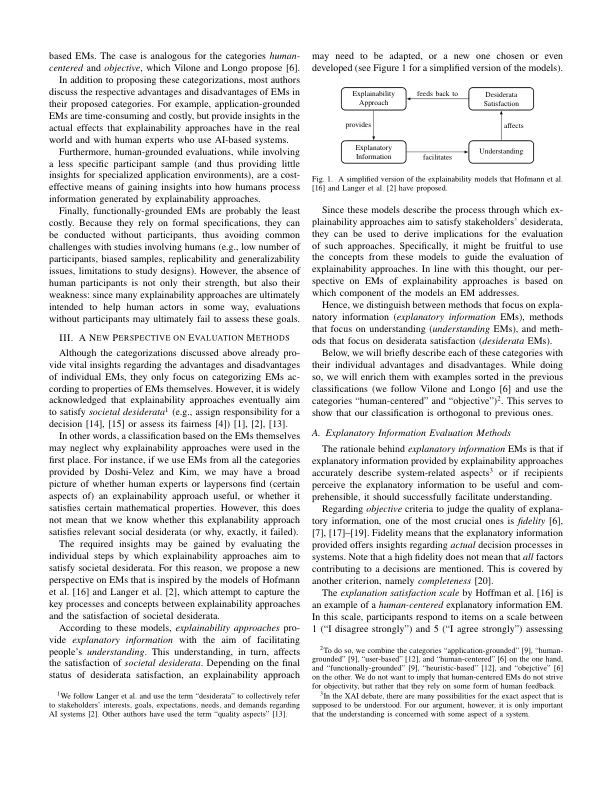

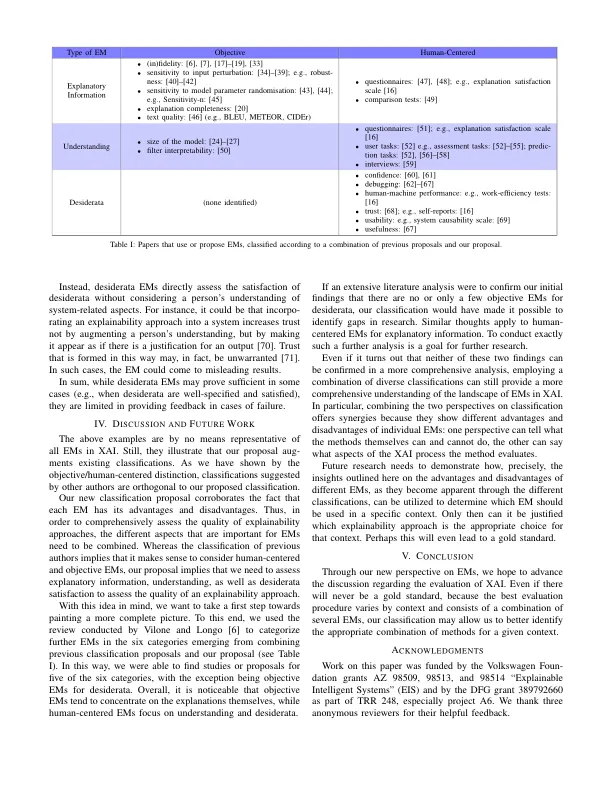

摘要 — 可解释人工智能 (XAI) 领域的一大挑战是如何评估可解释性方法。已经提出了许多评估方法 (EM),但尚未建立黄金标准。几位作者根据 EM 本身的特点将可解释性方法的 EM 分为几类(例如,基于启发式、以人为本、基于应用、基于功能)。在本愿景论文中,我们提出也可以根据 EM 所针对的 XAI 过程的各个方面对 EM 进行分类。基于阐明 XAI 中主要过程的模型,我们提出存在解释信息 EM、理解 EM 和需求 EM。这种新颖的观点旨在通过较少关注 EM 本身而是关注可解释性方法想要实现的目标(即提供良好的解释信息、促进理解、满足社会需求)来增强其他作者的观点。我们希望这两种观点的结合能让我们更全面地评估可解释性方法的优缺点,帮助我们做出更明智的决定,决定使用哪种方法或如何改进它们。索引术语——可解释性、可解释人工智能、XAI、评估、评估方法、指标、研究

可解释人工智能(XAI)评估方法的新视角