机构名称:

¥ 1.0

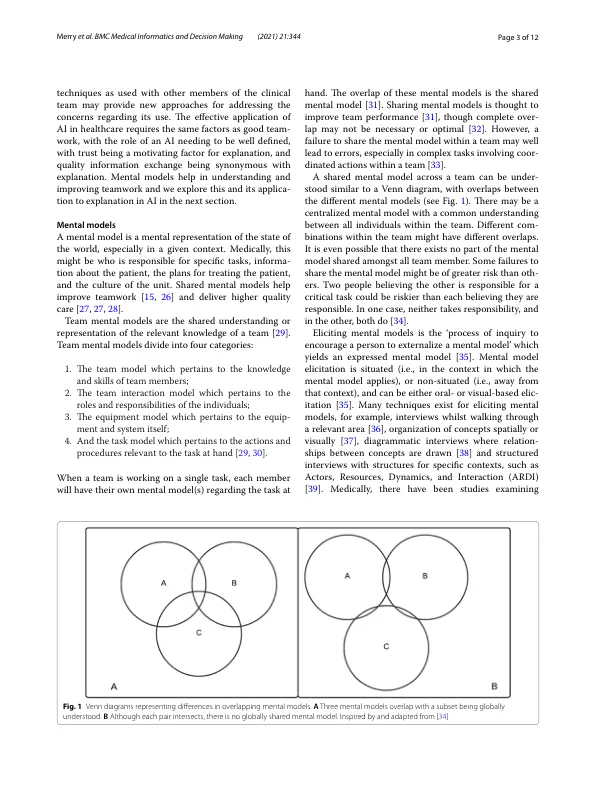

摘要背景:人们普遍担心在医疗保健等敏感环境中使用黑盒建模方法。尽管性能有所提升且备受炒作,但这些问题阻碍了人工智能 (AI) 的普及。人们认为可解释的人工智能有助于缓解这些担忧。但是,现有的可解释定义并未为这项工作奠定坚实的基础。方法:我们批评了最近关于以下文献的评论:团队中人工智能的代理;心理模型,尤其是它们应用于医疗保健时,以及它们引出的实际方面;以及现有和当前的可解释性定义,尤其是从人工智能研究人员的角度来看。在此文献的基础上,我们创建了可解释的新定义和支持术语,提供了可以客观评估的定义。最后,我们将可解释的新定义应用于三个现有模型,展示了它如何应用于先前的研究,并为基于此定义的未来研究提供指导。结果:现有的解释定义以全球适用性为前提,并未解决“谁可以理解?”的问题。如果将人工智能视为团队成员,那么引出心理模型可以比作创建可解释的人工智能。在此基础上,我们根据模型的背景来定义可解释性,包括模型和解释的目的、受众和语言。作为示例,此定义应用于手术室团队中的回归模型、神经网络和人类心理模型。结论:现有的解释定义在确保解决实际应用问题方面存在局限性。根据应用背景来定义可解释性会迫使评估与模型的实际目标保持一致。此外,它将允许研究人员明确区分针对技术受众和普通受众的解释,从而允许对每种解释应用不同的评估。关键词:可解释性、xAI、黑盒模型、心理模型

定义可解释人工智能的心理模型方法

主要关键词