机构名称:

¥ 1.0

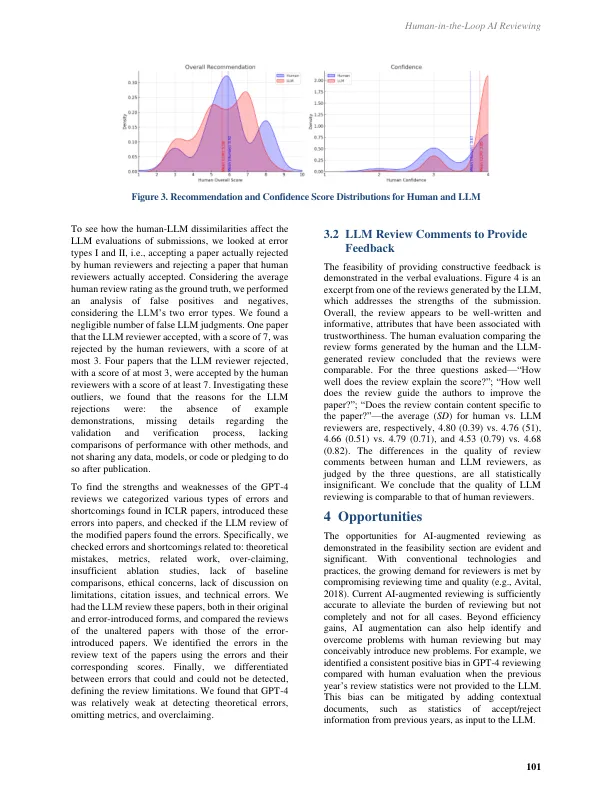

人工智能在学术工作中的前景令人着迷且易于想象,但所涉及的风险往往难以察觉且通常不易暴露。在这篇评论文章中,我们探讨了使用大型语言模型 (LLM) 审查学术论文的可行性、机会和风险,同时让人类参与其中。我们尝试使用 GPT-4 扮演审稿人的角色,以展示我们遇到的机会和风险以及减轻它们的方法。评审是根据会议评审表进行的结构化,其双重目的是评估提交的内容以供编辑决策,并根据预定义的标准为作者提供建设性的反馈,这些标准包括贡献、合理性和展示。我们通过评估和比较 LLM 评审与人工评审来证明可行性,得出结论,当前的人工智能增强评审足够准确,可以减轻评审负担,但并非完全如此,也并非适用于所有情况。然后,我们列举了人工智能增强评审的机会并提出了开放性问题。接下来,我们确定了人工智能增强评审的风险,强调了偏见、价值错位和滥用。最后,我们提出了管理这些风险的建议。

人机协同 AI 审核:可行性、机遇和风险