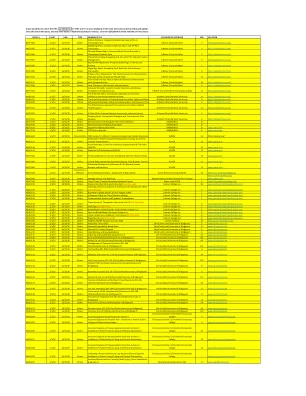

机构名称:

¥ 1.0

首先,以受邀演讲、投稿论文和参与结构化讨论的形式,解决表征对齐的问题以及机器学习可解释性和安全性领域的相关问题,这些问题都是 ICLR 和其他机器学习会议持续关注的问题。这些问题源于以下中心主题:智能系统何时以及为何学习对齐的表示,以及科学家和工程师如何干预这种对齐?例如,由于大型模型在各个行业和科学领域的使用增加(例如,Gemini Team Google,2023 年;OpenAI,2023 年),该领域需要找到更好地解释和最终理解这些系统的方法。模型可解释性与这些系统形成的表示紧密相关(参见 Doshi-Velez 和 Kim,2017 年;Sucholutsky 等人,2023 年;Lampinen 等人,2024 年;Muttenthaler 等人,2024 年)。因此,更好地理解表示及其与参考系统(通常是人类目标)的一致性,反过来会促进模型的可解释性和可解释性。另一组问题集中于表示学习与计算神经科学和认知科学之间的联系。这些领域已经相对独立地开发了评估和增强人工智能与人类智能系统在神经和行为层面的一致性的方法(Collins 等人,2024 年;Muttenthaler 等人,2024 年;Dorszewski 等人,2024 年;Bonnen 等人,2024 年;Sundaram 等人,2024 年)。我们的研讨会旨在就确定衡量和增强人工智能与人类智能系统一致性的最有用方法展开公开讨论。

ICLR 2025 表征对齐 (Re2 ...) 研讨会

主要关键词