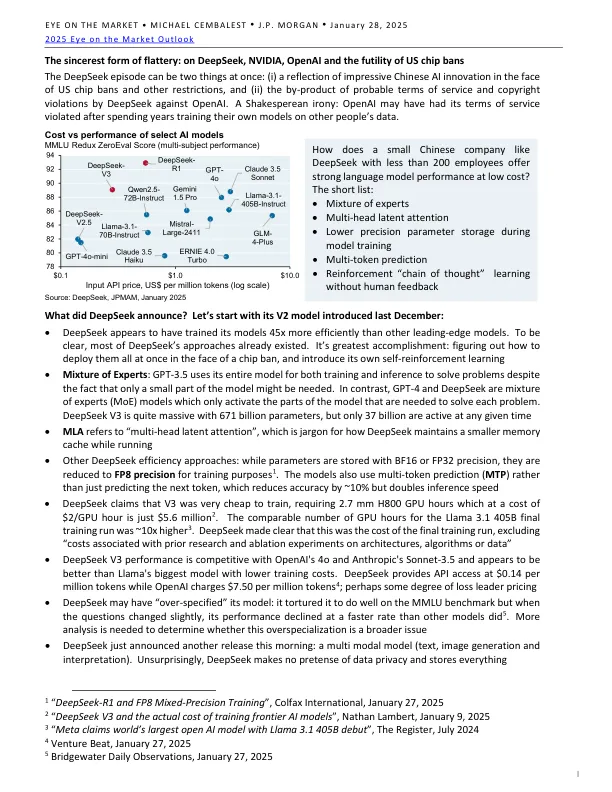

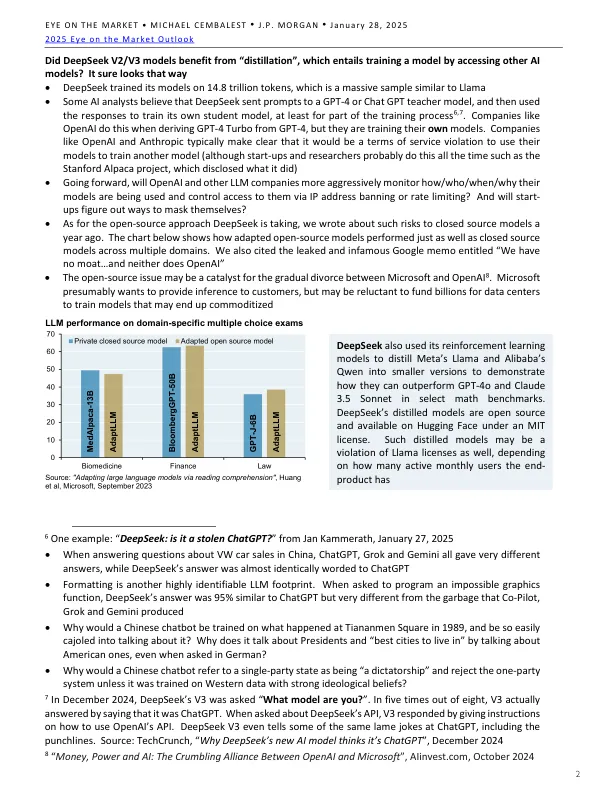

•DeepSeek似乎比其他前沿模型更有效地训练了45倍的型号。清楚,DeepSeek的大多数方法已经存在。这是最大的成就:面对筹码禁令,弄清楚如何立即部署它们,并介绍其自身的自我增强学习•专家的混合:GPT-3.5使用其整个模型来解决培训和推理,尽管可能只需要一小部分模型。相比之下,GPT-4和DeepSeek是专家(MOE)模型的混合物,它们仅激活解决每个问题所需的模型的各个部分。DeepSeek V3的参数为6,710亿个,但在任何给定时间中只有370亿个活动•MLA是指“多头潜能”,这是对DeepSeek保持较小的存储器的行话,而在运行的过程中,•其他deepseek效率方法在运行•与BF16或FP3精确的过程中存储的其他deepseek效率方法,这些方法是供应fp3的精确量,它们是精确的。模型还使用多言语预测(MTP),而不仅仅是预测下一代币,这将准确性降低了约10%,但提出速度却增加了一倍,但DeepSeek声称V3非常便宜,需要2.7毫米H800 GPU小时,这是$ 2/GPU时的费用,只需$ 2/GPU时,只有5600万美元2美元。Llama 3.1 405B最终训练运行的GPU小时数量可比数量高约10倍3。需要进行更多的分析来确定这种过度专业化是否是一个更广泛的问题•DeepSeek今天早上刚刚宣布了另一个版本:多模式模型(文本,图像生成和解释)。DeepSeek明确指出,这是最终培训的成本,不包括“与先前的研究和消融实验相关的架构,算法或数据相关的成本”•DeepSeek V3性能与OpenAI的4O和Anthropic的SONNET-3.5竞争,并且似乎比Llama最大的培训成本更好。DeepSeek提供的API访问为每百万个令牌0.14美元,而Openai则收取每百万个令牌4 $ 750;也许某种程度的损失领导者定价•DeepSeek可能“过度指定”其模型:它在MMLU基准测试上做得很好,但是当问题略有变化时,其性能的下降速度比其他型号更快。毫不奇怪,DeepSeek不假装数据隐私并存储所有内容

市场上的市场

主要关键词