机构名称:

¥ 1.0

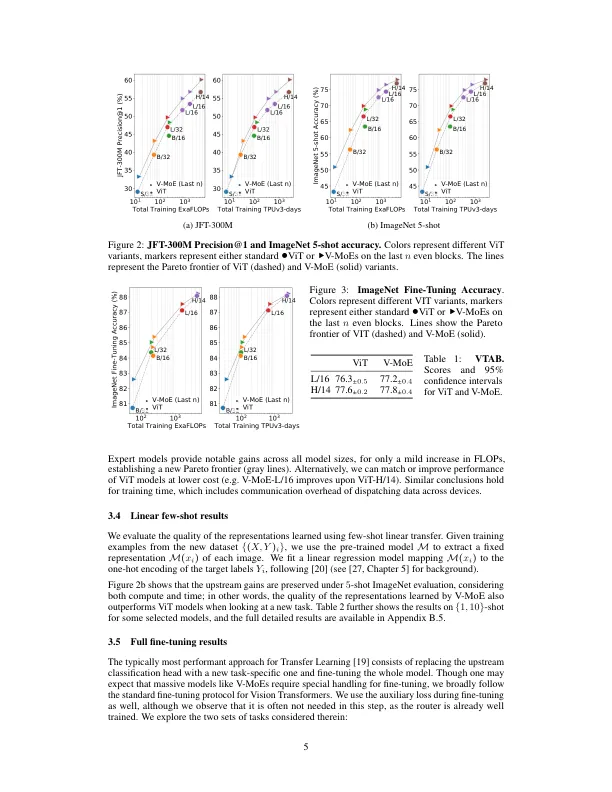

稀疏门控混合专家网络 (MoE) 在自然语言处理中表现出色。然而,在计算机视觉中,几乎所有高性能网络都是“密集的”,也就是说,每个输入都由每个参数处理。我们提出了一种视觉 MoE (V-MoE),它是 Vision Transformer 的稀疏版本,具有可扩展性,可与最大的密集网络相媲美。当应用于图像识别时,V-MoE 的性能可与最先进的网络相媲美,同时在推理时只需要一半的计算量。此外,我们提出了一种路由算法的扩展,该算法可以对整个批次中每个输入的子集进行优先级排序,从而实现自适应的每幅图像计算。这使得 V-MoE 能够在测试时权衡性能并顺利计算。最后,我们展示了 V-MoE 扩展视觉模型的潜力,并训练了一个 15B 参数模型,在 ImageNet 上达到了 90.35% 的准确率。

利用稀疏混合专家扩展视野

主要关键词