机构名称:

¥ 2.0

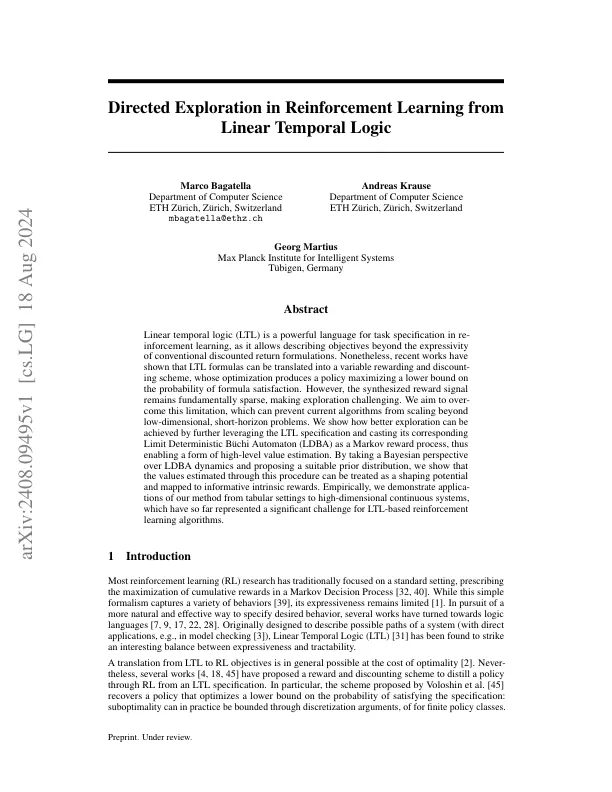

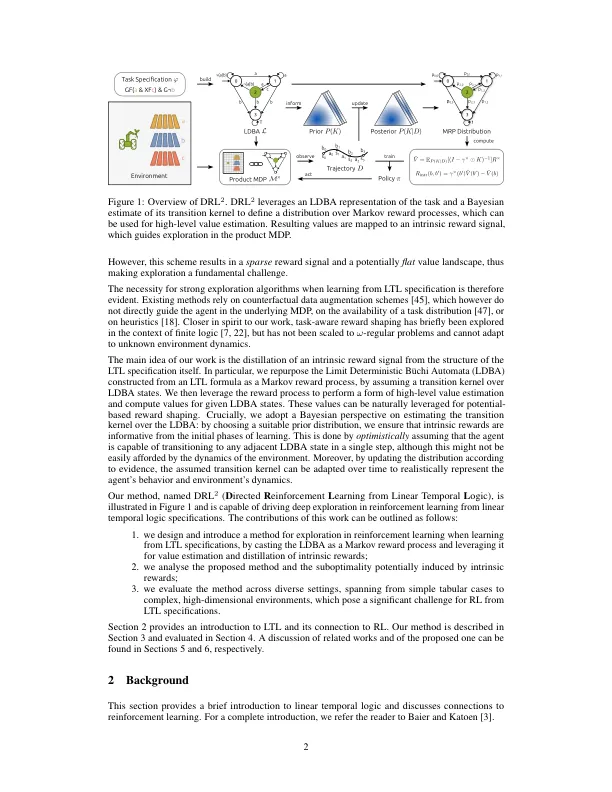

线性时间逻辑(LTL)是一种在进行信息学习中的任务规范的强大语言,因为它允许描述超出常规折扣返回公式的表达性的目标。尽管如此,最近的作品表明,LTL公式可以转化为可变的奖励和折扣方案,其优化产生了最大程度地提高公式满意度的可能性的策略。但是,合成的奖励信号从根本上仍然很稀疏,这使探索具有挑战性。我们的目标是超越此限制,这可以防止当前的算法超越低维,短距离问题。我们展示了如何通过进一步利用LTL规范并将其相应极限确定性Büchi自动机(LDBA)作为马尔可夫奖励过程来实现更好的探索,从而实现了高级价值估计的形式。通过对LDBA动力学采取贝叶斯的观点并提出合适的先前分布,我们表明,通过此过程估计的值可以视为塑造潜力,并映射到信息丰富的内在奖励。从经验上讲,我们证明了我们从表格设置到高维连续系统的方法的应用,到目前为止,这对基于LTL的增强式学习算法表示了重大挑战。

从线性时间逻辑

主要关键词