机构名称:

¥ 1.0

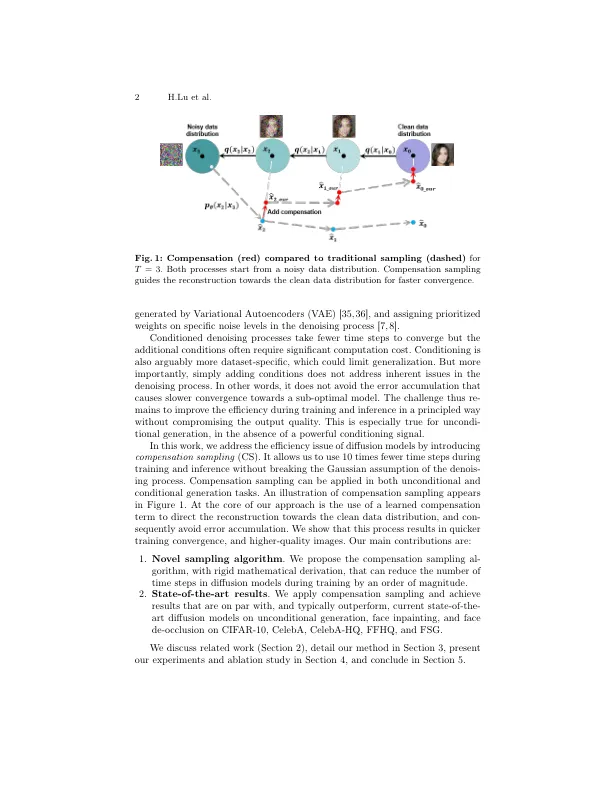

摘要。扩散模型在图像一般方面具有出色的质量,但以一定的代价。迭代denoising需要许多时间步骤来产生高保真图像。由于目标数据的初始不准确重建,重建误差的积累至关重要的限制。这会导致质量降低,收敛速度较慢。为了解决这些问题,我们提出了补偿抽样,以指导生成目标领域。我们引入了一个用U-NET实施的薪酬术语,该薪酬添加了可忽略的培训间接费用。我们的方法是灵活的,我们将其在基准数据集Cifar-10,Celeba,Celeba-HQ,FFHQ-256和FSG上的无条件生成,面对介绍和面对外划分中的应用。我们的方法始终从图像质量方面产生最先进的结果,同时加速了在训练过程中以最高数量级收敛的转化过程。

补偿抽样,以改善扩散模型的收敛性

主要关键词