机构名称:

¥ 2.0

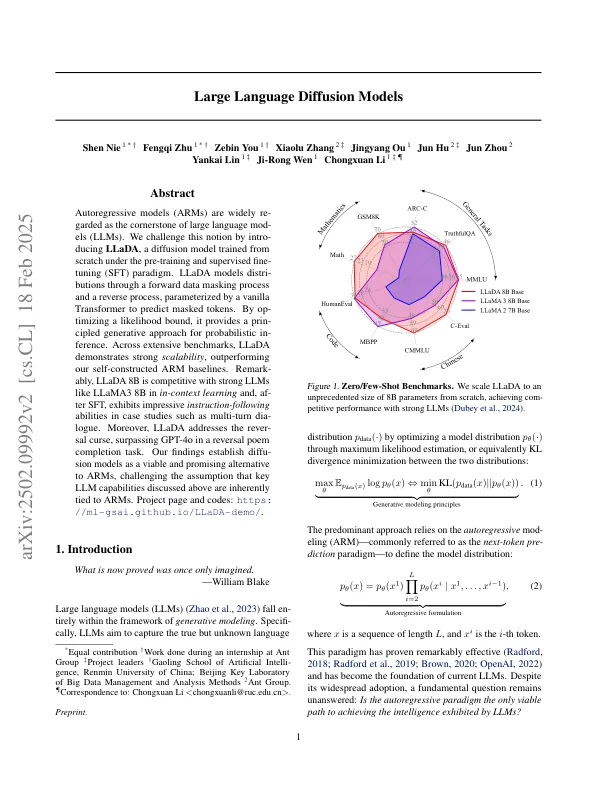

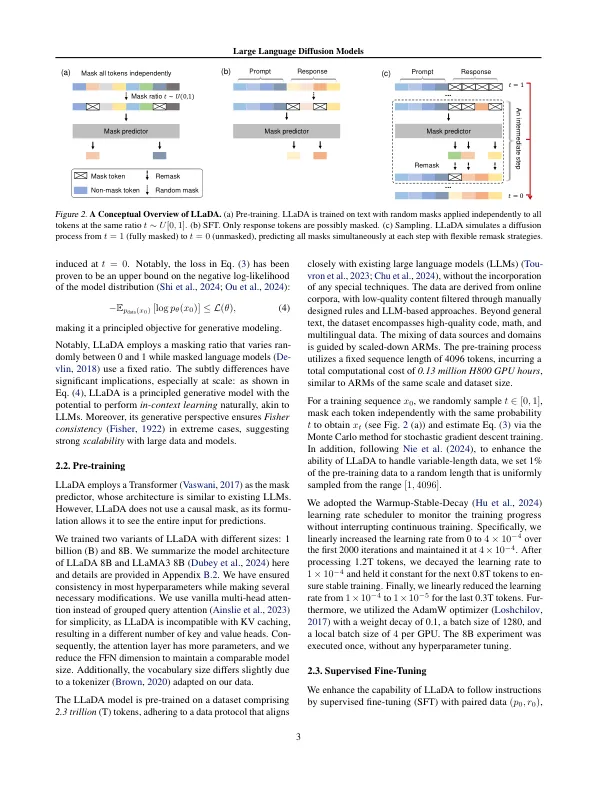

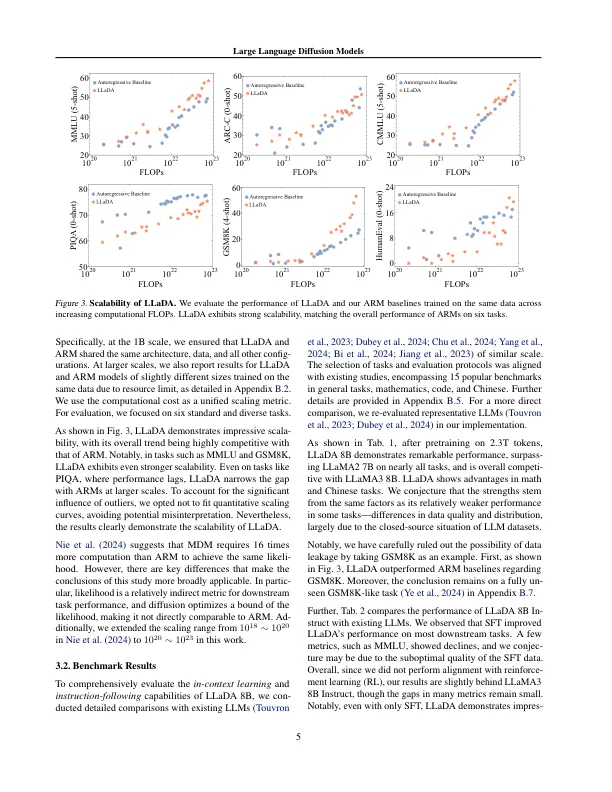

自回旋模型(武器)被广泛地成为大型语言模型(LLMS)的基石。我们通过介绍LLADA挑战了这一概念,这是一种扩散模型,该模型在训练和监督的细调(SFT)范式下从头开始训练。llada通过向前数据掩盖过程和反向过程进行分散模型,该过程由香草变压器参数列出以预测掩盖的令牌。通过操作可能性结合的可能性,它为概率引发提供了一种限制的生成方法。在广泛的基准测试中,Llada表现出强大的可伸缩性,表现优于我们的自我建造的手臂基线。明显地,LLADA 8B具有强大的LLM,例如LLAMA3 8B在秘密学习中,并且在SFT之后,在诸如多转变型号之类的案例研究中表现出令人印象深刻的跟随能力。此外,Llada解决了诅咒,在逆转诗的完成任务中超过了GPT-4O。我们的发现将扩散模型建立为武器的可行且有前途的替代方案,挑战了上面讨论的关键LLM功能固有地与武器相关的假设。项目页面和代码:https://ml-gsai.github.io/llada-demo/。

大语言扩散模型

主要关键词