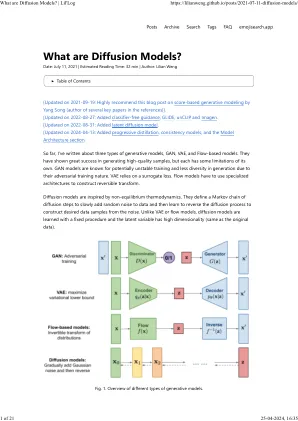

可以通过最大似然eS-定时(MLE)定义为X ML = Arg Max Max X Log P(Y | X)的最大似然性(MLE)的解决方案y = a x + n,可以概率地得出。尽管如此,如果向前操作员A是单数的,例如,当M 在这种情况下,仅使用观察到的测量y仅使用观察到的y,即使在y = y = ax的无噪声场景中,也只能使用观察到的测量y唯一地恢复信号集x是不可行的。 由于a的空空间的非平凡性,因此出现了这一挑战。 为了减轻适应性,必须基于先验知识来限制可能解决方案的空间,因此必须合并一个额外的假设。 主要采用的框架提供了更有意义的解决方案是最大的后验(MAP)估计,该估计为x Map = arg max = arg max x [log p(y | x) + log p(x)],其中术语log p(x)封装了清洁图像x的先前信息。 随着时间的流逝,解决反问题的先验概念已经大大发展。 从经典上讲,许多方法论依赖于手工制作的先验,这些方法是分析定义的约束,例如稀疏性[10,31],低率[14,16],总变化[9],但要命名为少数,以增强重建。 随着深度学习模型的出现,先验已过渡到数据驱动,从而在重建质量方面产生了很大的提高[1,2,7,7,17,34]。 无监督的学习范式中的策略因学识渊博的先验方式而异(又称在这种情况下,仅使用观察到的测量y仅使用观察到的y,即使在y = y = ax的无噪声场景中,也只能使用观察到的测量y唯一地恢复信号集x是不可行的。由于a的空空间的非平凡性,因此出现了这一挑战。为了减轻适应性,必须基于先验知识来限制可能解决方案的空间,因此必须合并一个额外的假设。主要采用的框架提供了更有意义的解决方案是最大的后验(MAP)估计,该估计为x Map = arg max = arg max x [log p(y | x) + log p(x)],其中术语log p(x)封装了清洁图像x的先前信息。随着时间的流逝,解决反问题的先验概念已经大大发展。从经典上讲,许多方法论依赖于手工制作的先验,这些方法是分析定义的约束,例如稀疏性[10,31],低率[14,16],总变化[9],但要命名为少数,以增强重建。随着深度学习模型的出现,先验已过渡到数据驱动,从而在重建质量方面产生了很大的提高[1,2,7,7,17,34]。无监督的学习范式中的策略因学识渊博的先验方式而异(又称这些先验,无论是以受监督的或无监督的方式学习的,都已集成到地图框架中,以解决不适合的反问题。在监督范式中,对配对的原始图像的可用性和观察到的测量值的依赖也可能限制模型的通用性。结果,这种趋势已转向对无监督的兴趣的日益兴趣,在这种情况下,使用深层生成模型隐式或明确地学习了先生。

通过双层引导扩散模型

主要关键词