机构名称:

¥ 1.0

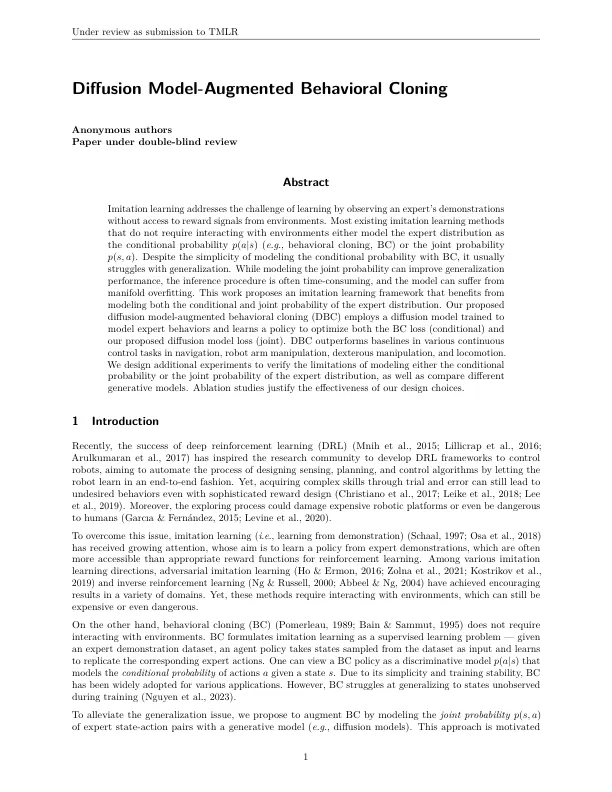

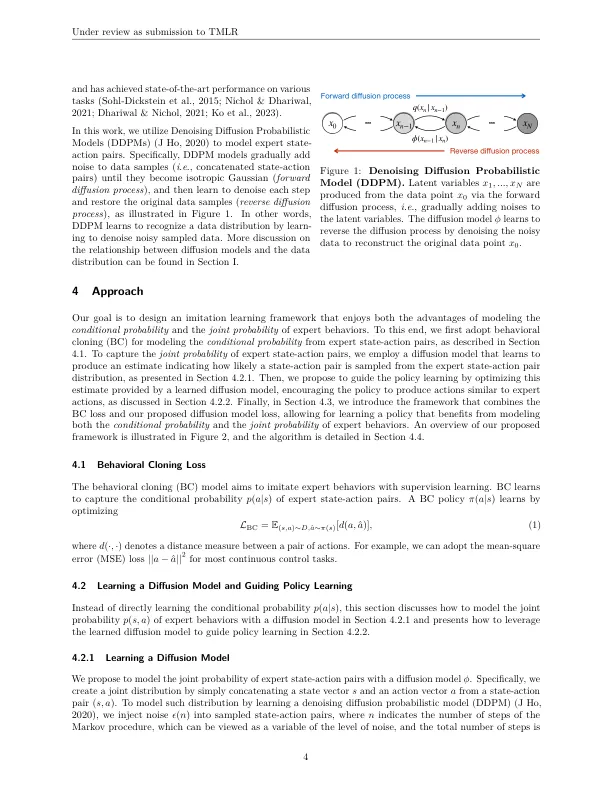

模仿学习通过观察专家的演示而无需访问环境奖励信号来解决学习的挑战。大多数现有的模仿学习方法不需要与环境进行交互,要么将专家分布建模为条件概率p(a | s)(e。g。,行为克隆,BC)或关节概率P(s,a)。尽管简单地用BC对条件概率进行建模,但它通常在概括方面挣扎。在建模关节概率可以提高概括性能时,推理过程通常是耗时的,并且模型可能会遭受过度拟合的歧视。这项工作提出了一个模仿学习框架,该框架从建模专家分布的条件和联合概率中受益。我们提出的扩散模型启动行为克隆(DBC)采用了一种扩散模型,该模型训练了建模专家行为,并学习了一项政策,以优化BC丢失(条件)和我们提出的扩散模型损失(关节)。DBC在导航,机器人臂操纵,灵活的操纵和运动中的各种连续控制任务中的表现优于基准。我们设计了其他实验,以验证对条件概率或专家分布的关节概率建模的局限性,并比较不同的生成模型。消融研究证明了我们的设计选择的有效性。

扩散模型的行为克隆

主要关键词