机构名称:

¥ 4.0

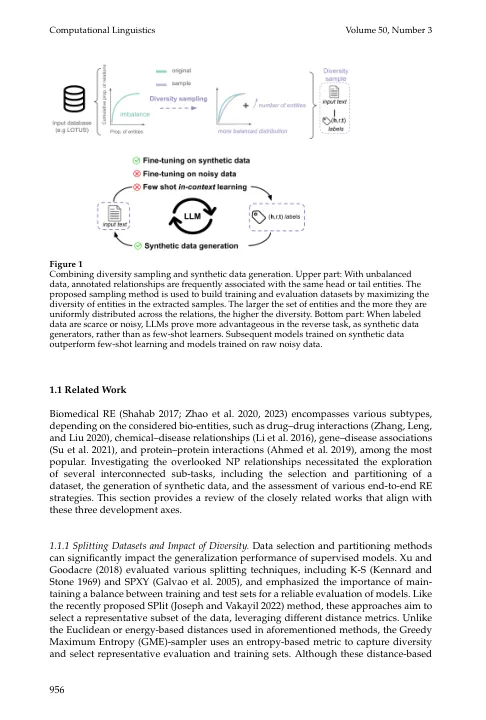

鉴于手动策展的资源密集型性质,评估集中选定项目的多样性很重要。量化训练集中的噪声后,以输入摘要的文本和预期的输出标签之间的差异形式,我们相应地探讨了不同的策略。将任务作为端到端的关系提取,我们评估了标准辅导(BioGPT,GPT-2和SEQ2REL)的性能,并使用开放的大语言模型(LLMS)(LLAMA 7B-65B)进行了少量学习。除了在几次射击设置中进行评估外,我们还探讨了开放LLM作为合成数据的潜力,并为此目的提出了新的工作流程。所有评估的模型在合成摘要而不是原始嘈杂数据时进行了实质性改进。我们提供表现最好的表现(F1得分= 59。0)天然产品关系端到端的MioGPT-LARGE模型以及所有培训和评估数据集。请访问https://github.com/idiap/abroad-re。

在未置换的生物医学领域中的关系提取