机构名称:

¥ 1.0

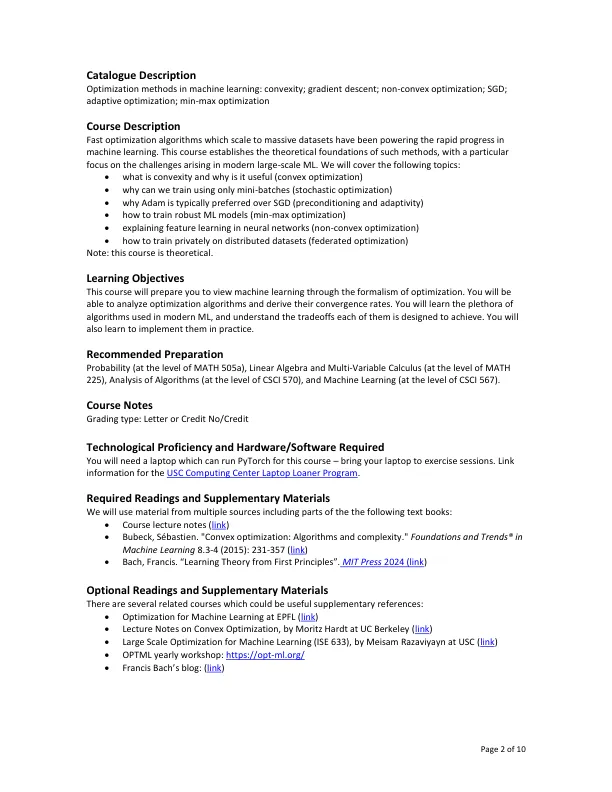

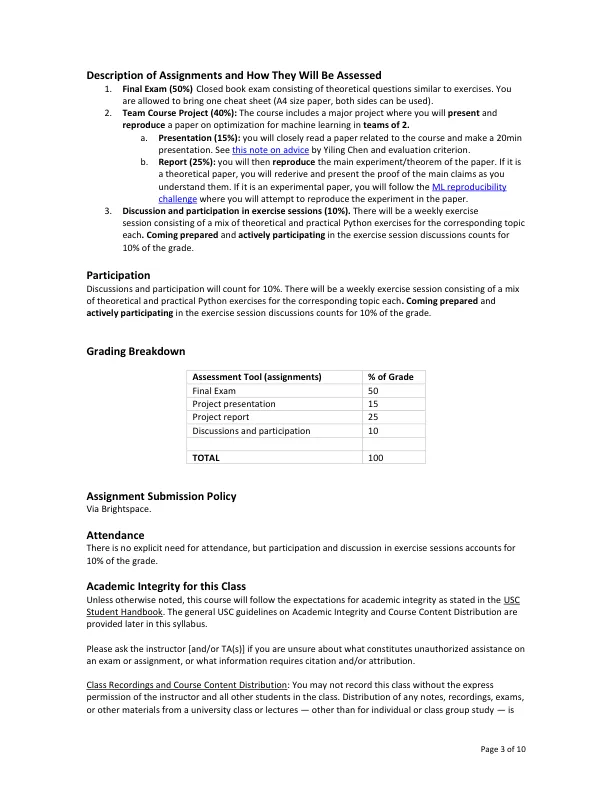

• what is convexity and why is it useful (convex optimization) • why can we train using only mini-batches (stochastic optimization) • why Adam is typically preferred over SGD (preconditioning and adaptivity) • how to train robust ML models (min-max optimization) • explaining feature learning in neural networks (non-convex optimization) • how to train privately on distributed datasets (federated optimization)注意:本课程是理论上的。学习目标本课程将使您通过优化的形式主义来查看机器学习。您将能够分析优化算法并得出其收敛速率。您将学习现代ML中使用的大量算法,并了解它们都旨在实现的权衡。您还将学会在实践中实施它们。建议的准备概率(在数学505A的级别),线性代数和多变量的演算(在数学225的水平上),算法分析(在CSCI 570的级别上)和机器学习(在CSCI 567的水平上)。课程注释类型:信用或信用编号/信用技术熟练程度和所需的硬件/软件您将需要一台可以在本课程中运行Pytorch的笔记本电脑 - 将笔记本电脑带到运动课程。USC计算中心笔记本电脑借贷程序的链接信息。所需的读数和补充材料我们将使用来自多个来源的材料,包括以下教科书的一部分:

CSCI 599:用于机器学习的优化

主要关键词