机构名称:

¥ 1.0

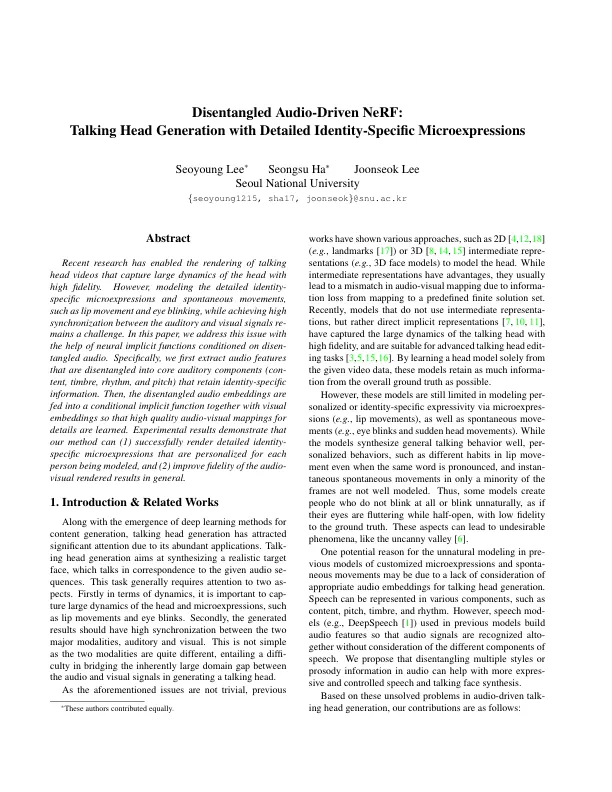

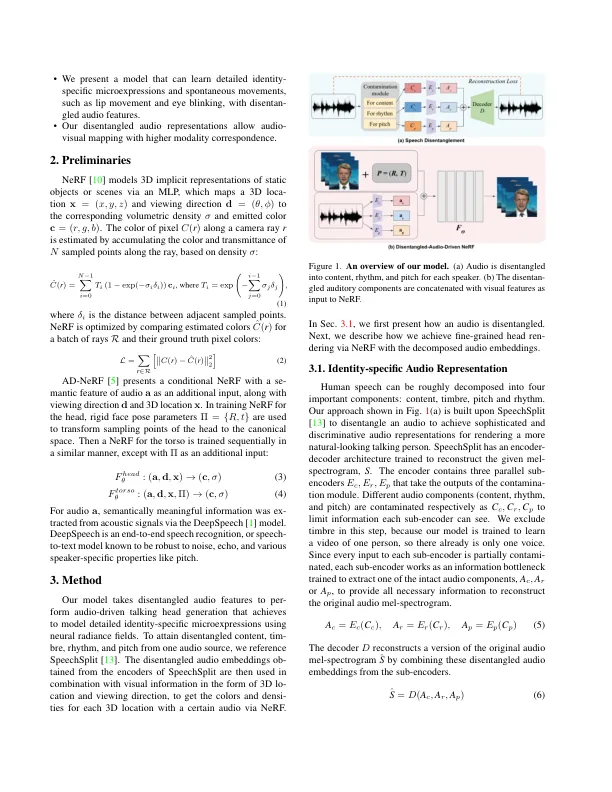

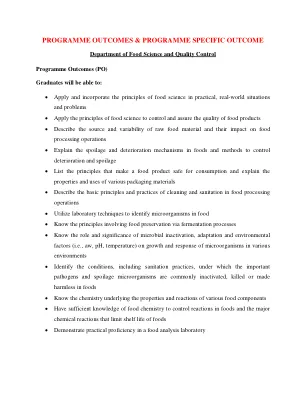

最近的研究使会说话的头视频的渲染能够捕捉到高富达的头部动态。然而,对详细的身份 - 特定的微表达和自发运动进行建模,例如唇部运动和眼睛闪烁,同时在听觉和视觉信号之间实现高度同步,这一挑战是一个挑战。在本文中,我们借助于散布的音频来解决此问题。具体来说,我们首先提取将保留特定于身份信息的核心听觉组件(content,timbre,ronythm和pitch)中脱离的音频功能。然后,散布的音频嵌入与视觉嵌入一起馈入条件隐式功能,以便学习高质量的视听映射以获取细节。实验结果表明,我们的方法可以(1)成功渲染针对每个正在建模的人的个性化的详细的身份 - 特定于特定的微表达,(2)提高了音频视觉渲染结果的保真度。

删除音频驱动的nerf:与特定身份的微表达式的交谈型

主要关键词