机构名称:

¥ 1.0

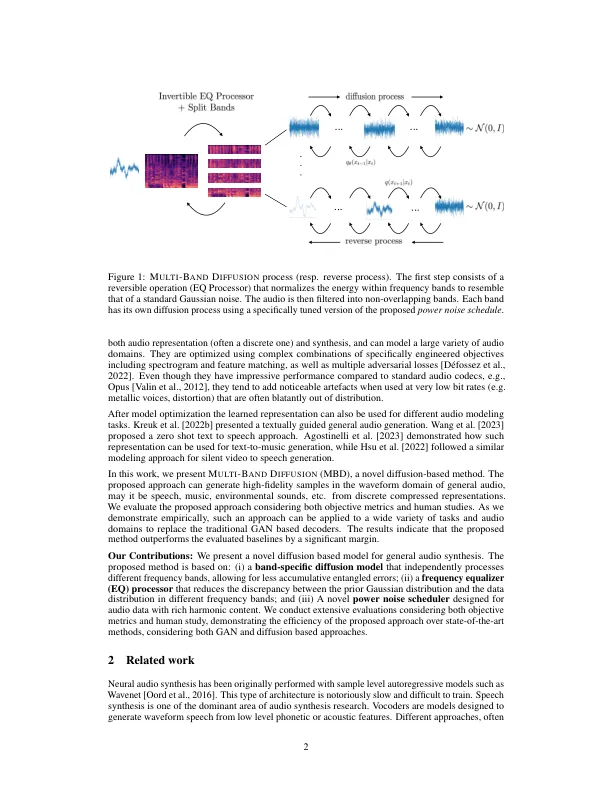

深层生成模型可以生成以各种类型表示形式(例如Mel-Spectrograms,Mel-Frequency cepstral系数(MFCC))生成的高保真音频。最近,此类模型已用于合成以高度压缩表示为条件的音频波形。尽管这种方法产生了令人印象深刻的结果,但它们很容易在调理有缺陷或不完美时产生可听见的伪影。另一种建模方法是使用扩散模型。但是,这些主要用作语音声码器(即以MEL光谱图为条件)或产生相对较低的采样率信号。在这项工作中,我们提出了一个高保真性的基于扩散的框架,该框架从低比二酸离散表示形式中生成任何类型的音频模式(例如,语音,音乐,音乐,环境声音)。以同样的比率,就感知质量而言,该方法的表现优于最先进的生成技术。培训和评估代码可在Face-Bookerearch/Audiocraft GitHub项目上找到。在以下链接上可用。

使用多...