机构名称:

¥ 2.0

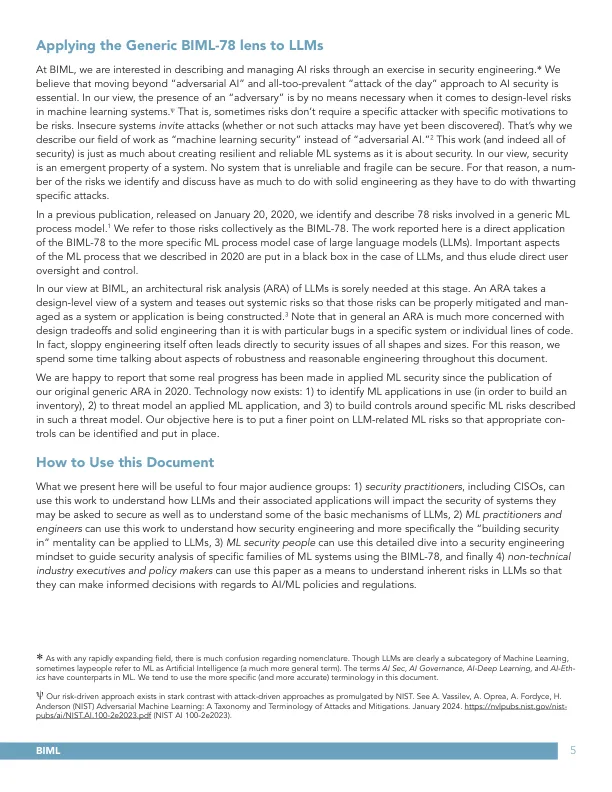

在BIML,我们有兴趣通过安全工程中的练习来描述和管理AI风险。*我们认为,超越“对抗性AI”和对AI安全性的全面质量的“每日攻击”方法至关重要。在我们看来,在机器学习系统中的设计级风险时,“对手”的存在绝对不是必需的。ψ是,有时风险不需要具有特定动机的特定攻击者。不安全的系统邀请攻击(是否发现了这种攻击)。这就是为什么我们将工作领域描述为“机器学习安全”而不是“对抗性AI”。 2这项工作(实际上是所有安全性)与创建弹性和可靠的ML系统一样多,与安全性有关。在我们看来,安全是系统的新兴属性。没有一个不可靠且脆弱的系统可以安全。因此,我们确定和讨论的许多风险与固体工程的关系与挫败特定攻击的关系与稳固的工程有关。

大型...

主要关键词