机构名称:

¥ 1.0

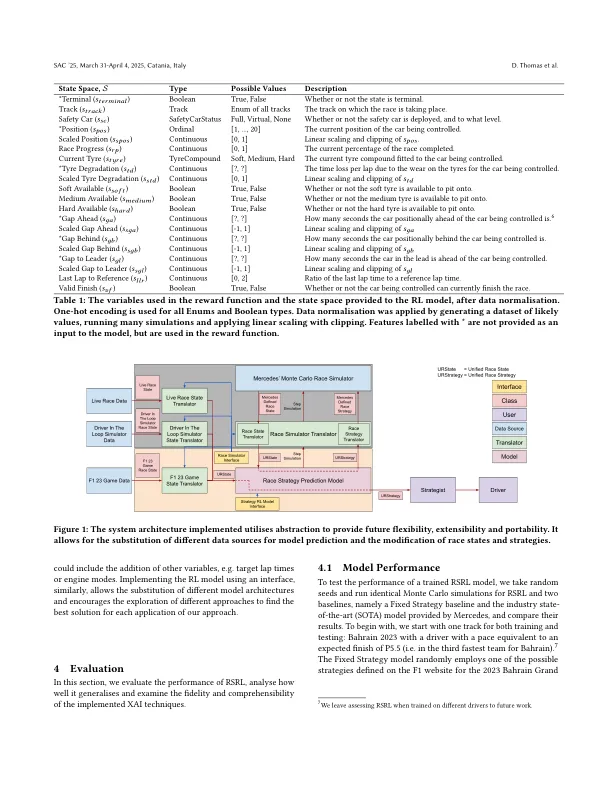

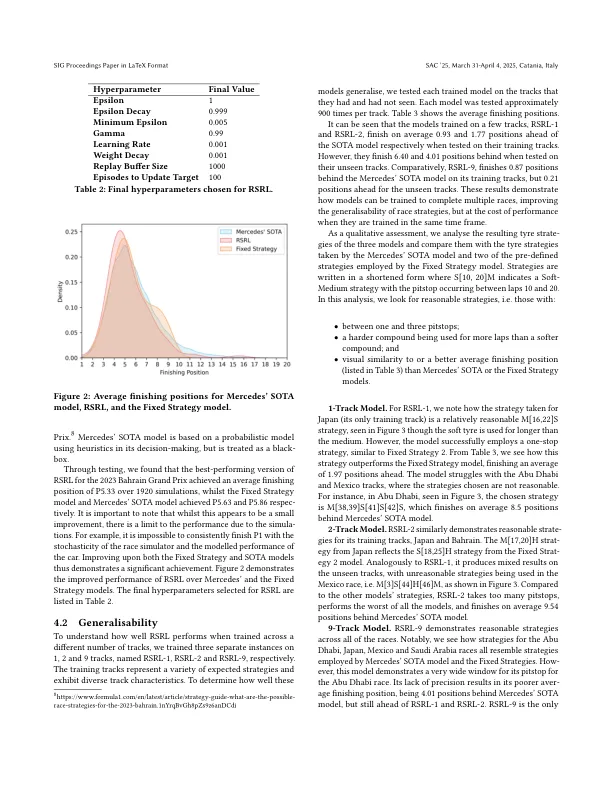

在一级方程式赛中,团队竞争开发自己的汽车,并在每场比赛中达到最高的完成位置。但是,在比赛中,球队无法更改汽车,因此他们必须通过比赛策略改善汽车的完成位置,即优化他们选择哪种轮胎化合物可以涂在汽车上以及何时这样做。在这项工作中,我们引入了强化学习模型RSRL(种族策略增强学习),以控制模拟中的种族策略,为基于硬编码和蒙特卡洛的种族策略提供了更快的替代品。控制汽车的速度等于P5.5的预期完成位置(P1代表第一名,P20是最后的位置),RSRL在我们的测试竞赛中达到了P5.33的平均饰面位置,即2023 Bahrain Grand Prix,胜过P5.63的最佳基线。然后,我们在一项概括性研究中证明了如何通过训练优先考虑一个轨道或多个轨道的性能。此外,我们以特征重要性,基于决策的替代模型以及决策树的反事实来补充模型预测,以改善用户对模型的信任。最后,我们提供了插图,这些插图体现了我们在现实情况下的方法,在模拟和现实之间取得了相似之处。

一级方程式竞赛策略的可解释的强化学习 *

主要关键词