机构名称:

¥ 2.0

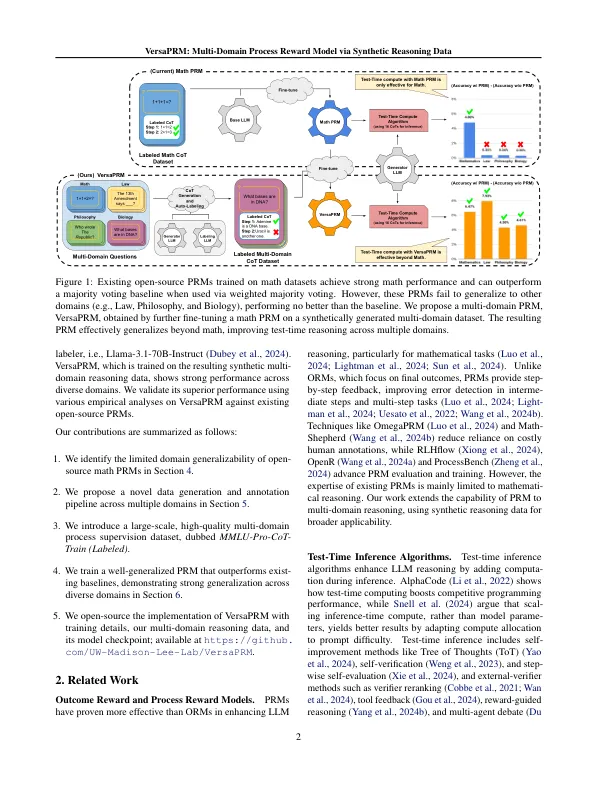

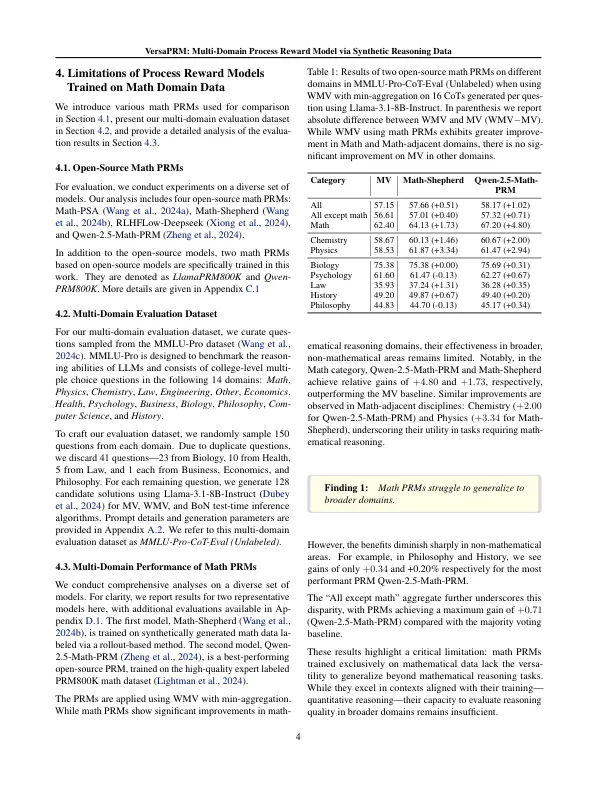

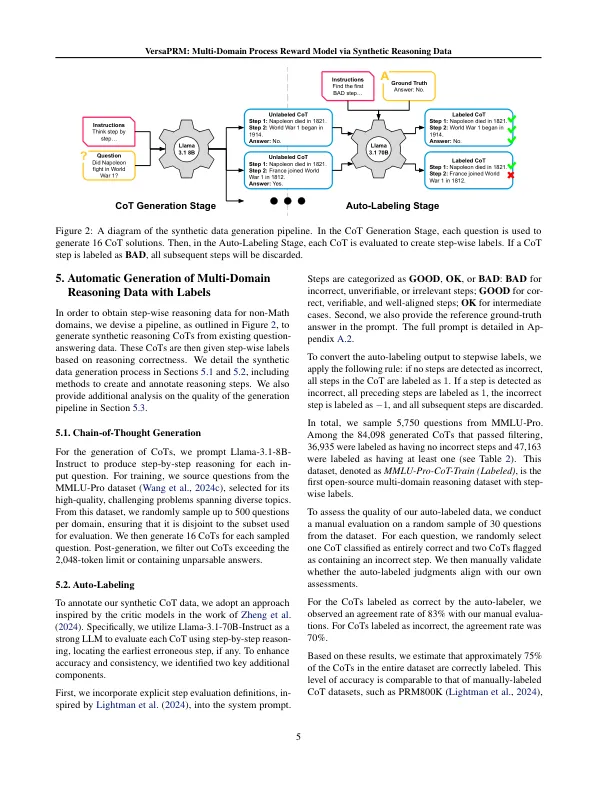

过程奖励模型(PRM)已被证明有效地通过杠杆化增加推理时间计算来增强大语模型(LLMS)的数学推理。曾经对他们进行数学数据的主要训练,并且尚未严格研究其对非数学领域的普遍性。回应,这项工作首先表明当前的PRM在其他域中的性能较差。为了解决这一限制,我们引入了VESTAPRM,这是一种使用我们的新数据生成和注释方法生成的合成推理数据的多域PRM。ver-saprm实现了各种领域的一致性增长。例如,在MMLU-PRO类别中,通过加权多数投票的VersAPRM,比大多数投票基线获得了7.9%的表现增长,超过了QWEN2.5-MATH-PRM的增长1.3%。我们通过开放VersaPRM的所有数据,代码和模型来进一步为社区做出贡献。

VersAPRM:通过合成推理数据