机构名称:

¥ 3.0

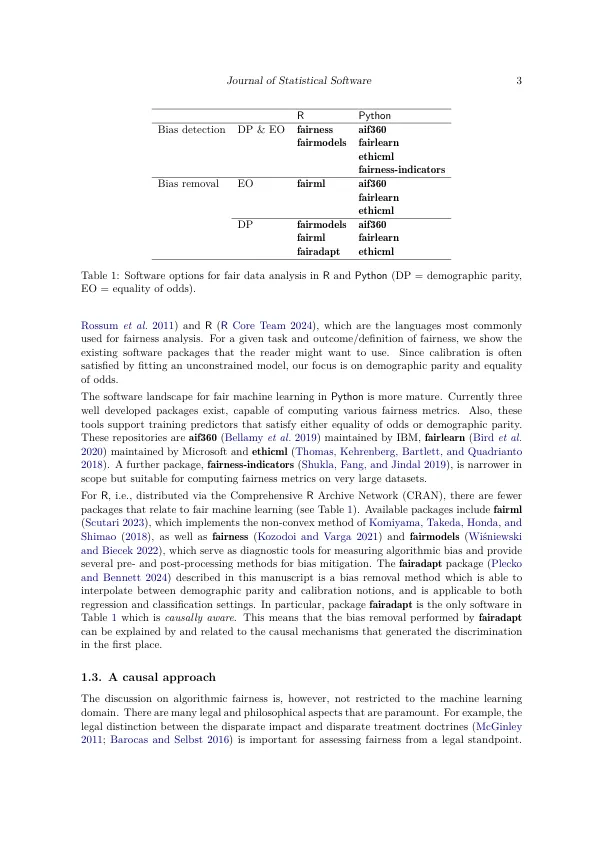

机器学习算法对于各种预测任务很有用,但它们也可以学习如何根据性别,种族或其他敏感属性来区分。这种实现产生了公平的机器学习领域,该领域旨在识别,量化和最终减轻这种算法偏见。此手稿描述了R软件包Fairadapt,该软件包实现了因果推理预处理方法。通过使用因果图形模型以及观察到的数据,该方法可用于解决“我的薪水是什么,如果我的性别/种族不同?”的假设问题。这种个人级别的反事实推理可以帮助消除歧视并有助于证明公正的决定。我们还讨论了适当的放松,假设某些因果关系从敏感属性到结果没有歧视性。

fairadapt:公平数据预处理的因果推理